Kluczowe wnioski:

- API do przetwarzania dokumentów umożliwia wyodrębnienie ustrukturyzowanych danych z posiadanych plików, takich jak PDF-y, obrazy czy e-maile.

- API do web scrapingu pozyskuje informacje z publicznych stron internetowych analizując kod HTML lub renderowaną treść.

- Wybór zależy od źródła danych: czy pracujesz na własnych plikach, czy potrzebujesz pobierać dane bezpośrednio z internetu.

- Często stosuje się hybrydowe rozwiązania: scrapowanie służy do pobrania dokumentów, a przetwarzanie do wydobycia wartościowego JSON.

API do przetwarzania dokumentów vs API do web scrapingu

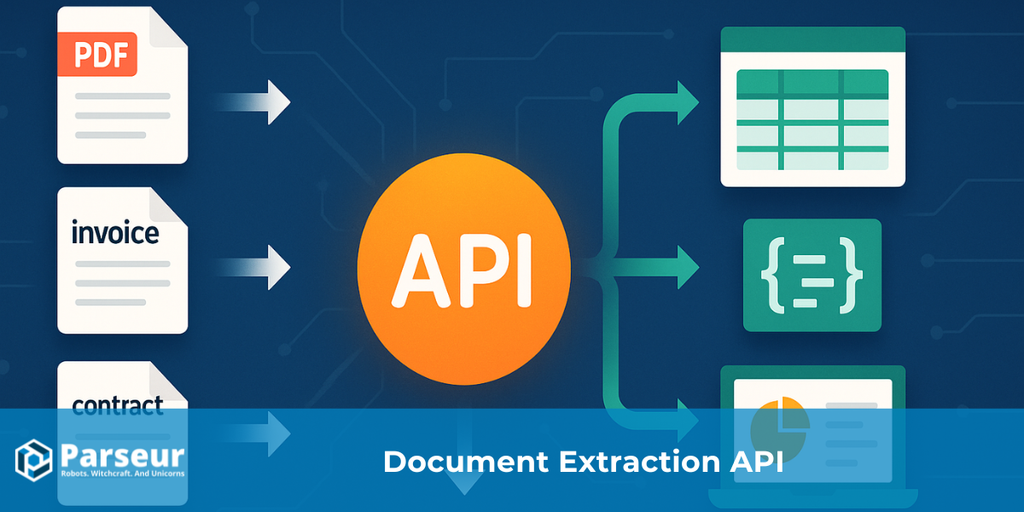

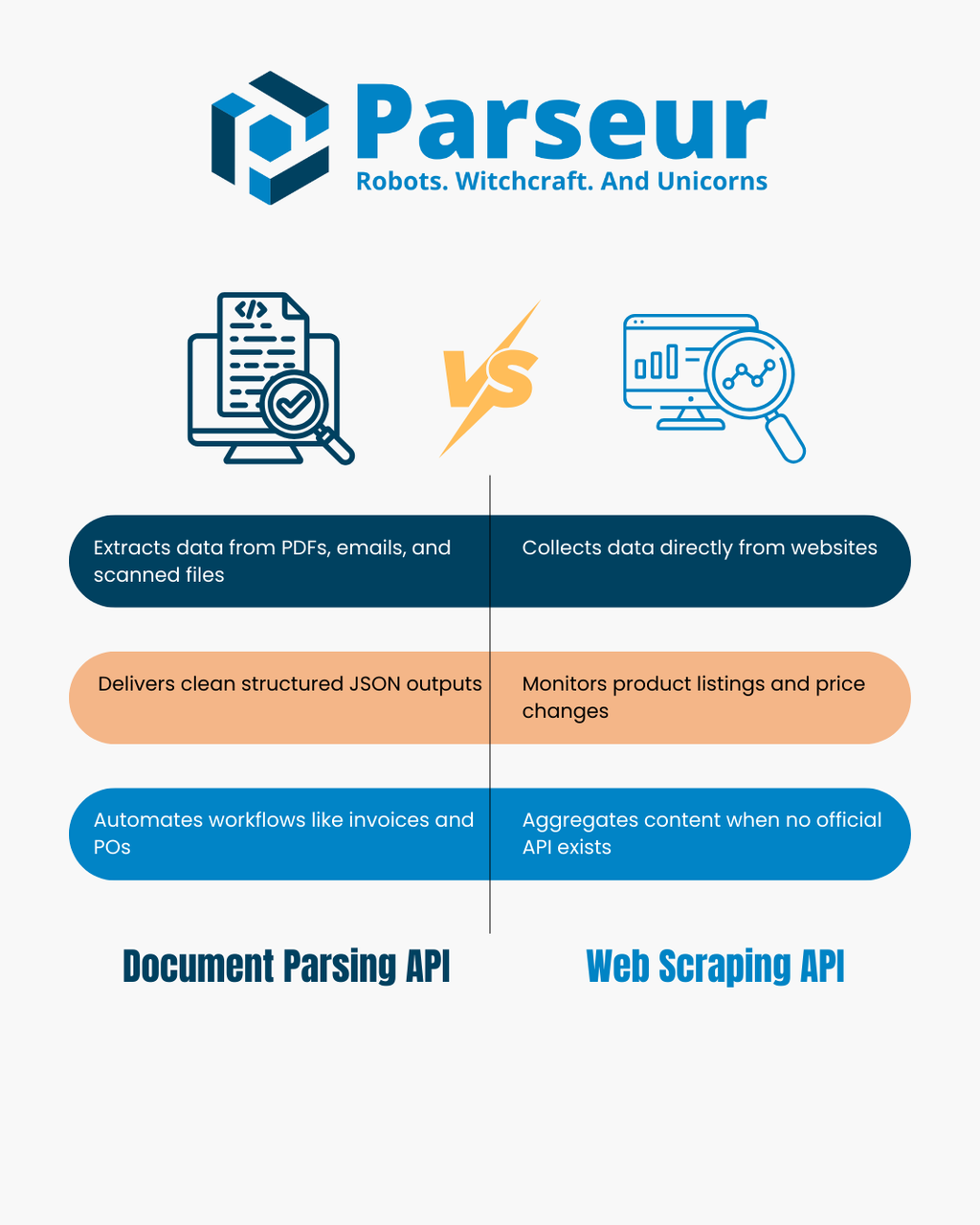

API do przetwarzania dokumentów konwertuje pliki takie jak PDF-y, zeskanowane obrazy i e-maile w ustrukturyzowany JSON. Narzędzie analizuje układ oraz tekst dokumentu, by wyodrębnić pary klucz-wartość i tabele, co znacząco usprawnia automatyzację zadań, takich jak obsługa faktur, śledzenie zamówień czy import e-maili do bazy danych.

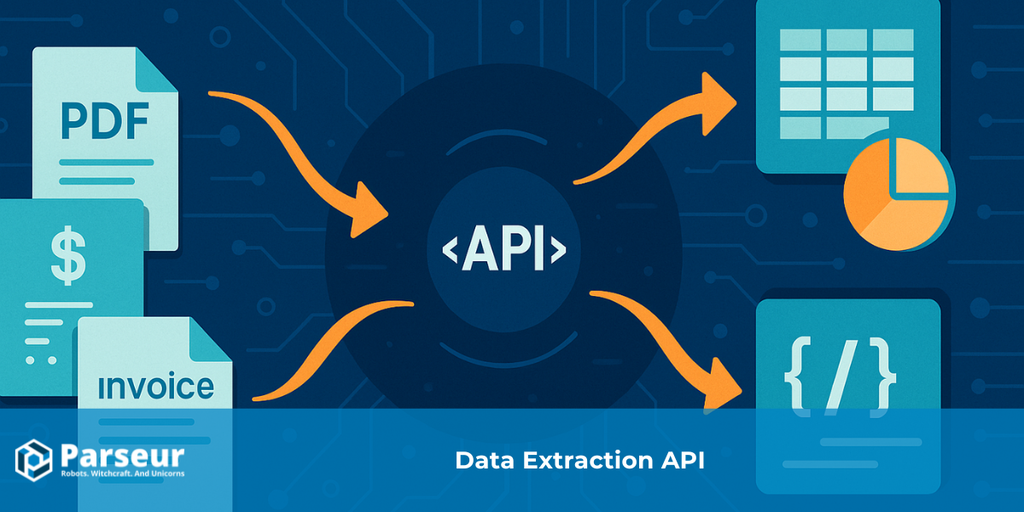

API do web scrapingu gromadzi dane bezpośrednio ze stron internetowych dzięki programowemu pobieraniu i analizie kodu HTML lub renderowanej zawartości DOM. Jest wykorzystywane głównie wtedy, gdy brak oficjalnego API i umożliwia monitorowanie list produktów, śledzenie cen, agregowanie newsów czy budowanie własnych zbiorów danych.

Obydwa rozwiązania umożliwiają pozyskiwanie danych, lecz różnią się źródłem: API do przetwarzania dokumentów operują na plikach, które posiadasz, a API do web scrapingu koncentrują się na zbieraniu danych ze stron internetowych. W tym artykule porównujemy ich możliwości i ograniczenia, prezentujemy praktyczne drzewo decyzyjne, tabelę porównawczą i scenariusze wdrożeń. Po więcej kontekstu sprawdź nasz przewodnik po API Ekstrakcji Danych.

Jak działają API do przetwarzania dokumentów i API do web scrapingu

Obie technologie służą ekstrakcji danych, ale rozwiązują zupełnie inne wyzwania i mają odmienny charakter działania. Świadomość, jak działają w praktyce, przyspiesza właściwy wybór rozwiązania dla Twojego biznesu.

Zgodnie z badaniem Scrapingdog 34,8% deweloperów korzysta dziś z API do web scrapingu, co pokazuje rosnące zainteresowanie gotowymi narzędziami do ekstrakcji danych w miejsce własnych, ręcznych skryptów.

API do przetwarzania dokumentów

API do przetwarzania dokumentów skupia się na wydobyciu ustrukturyzowanych informacji z plików, które już posiadasz lub legalnie otrzymujesz. Należą do nich PDF-y, skany, e-maile z załącznikami czy pliki biurowe. Zamiast manualnej pracy, API przetwarza układ i treść dokumentów, automatycznie wyciągając najważniejsze dane.

- Dane wejściowe: PDF-y, skany, obrazy, e-maile, pliki biurowe.

- Dane wyjściowe: Ustrukturyzowany JSON z polami klucz-wartość, tabelami i zdefiniowanymi polami.

- Jak działa: Dzięki technologiom OCR i regułom przetwarzania analizuje tekst, liczby oraz układ dokumentu i mapuje dane do spójnego formatu – gotowego do użycia np. w CRM, ERP, bazach danych.

- Typowe zastosowania: Automatyzacja faktur i paragonów, wydobywanie zamówień, analiza wyciągów finansowych, przetwarzanie dużych ilości formularzy klientów. Przetwarzanie dokumentów to również efektywna zamiana e-maili na dane strukturalne, wykorzystywane w narzędziach takich jak Zapier, Make czy n8n.

API do web scrapingu

API do web scrapingu pobiera dane z publicznie dostępnych stron internetowych. W przeciwieństwie do plików, tu punktem startowym są adresy URL – API pobiera HTML lub renderowaną stronę i wyodrębnia informacje poprzez selektory CSS/XPath lub skrypty JavaScript.

- Dane wejściowe: Adresy URL, surowy HTML lub endpointy JSON z internetu.

- Dane wyjściowe: Ustrukturyzowany JSON lub CSV z wyodrębnionymi informacjami – gotowe do dalszego przetwarzania lub integracji.

- Jak działa: API ładuje stronę, analizuje DOM, identyfikuje pożądane pola i wyciąga takie wartości jak nazwy produktów, ceny, nagłówki artykułów. Rozbudowane narzędzia umożliwiają obsługę proxy i omijanie zabezpieczeń antybotowych dla masowego pobierania danych.

- Typowe zastosowania: Monitorowanie cen e-commerce, zbieranie katalogów produktów, agregacja newsów, śledzenie ogłoszeń o pracę, pozyskiwanie danych tam, gdzie brak oficjalnego API.

API do przetwarzania dokumentów najlepiej sprawdza się przy pracy z plikami i dokumentami, natomiast API do web scrapingu daje najlepsze rezultaty przy zbieraniu danych z internetowych serwisów publicznych.

Drzewo decyzyjne: czego potrzebujesz?

Wybór pomiędzy API do przetwarzania dokumentów a API do web scrapingu zależy głównie od źródła danych i celu biznesowego. Oto praktyczne drzewo decyzyjne, które ułatwia podjęcie odpowiedniej decyzji.

!

Czy twoje źródło danych to dokument (PDF, obraz, załącznik e-mail), który legalnie posiadasz?

→ Użyj API do przetwarzania dokumentów. Przetworzy pliki na czysty JSON, wyodrębni kluczowe dane oraz szczegóły z tabel – bez potrzeby ręcznego przepisywania.

Czy źródłem są publiczne strony internetowe lub ogólnodostępne dane online?

→ Użyj API do web scrapingu. Pozwala ono pobierać HTML czy renderowany DOM i wyciągać wymagane dane, np. listy produktów czy aktualności branżowe.

Czy obsługujesz zarówno dokumenty, jak i strony internetowe?

→ Wtedy idealne jest podejście hybrydowe. Przykład: scraper pobiera PDF-y ze stron, a potem API do przetwarzania wydobywa z nich ustrukturyzowane dane.

Czy kluczowe są dla ciebie tabele lub szczegółowe pozycje (faktury, zamówienia, paragony)?

→ Tutaj szczególnie dobrze sprawdza się API do przetwarzania dokumentów. Dostarcza dokładne, powtarzalne wyniki na bazie schematów.

Czy zależy ci na regularnych aktualizacjach w czasie rzeczywistym (np. zmiany cen, nowe artykuły)?

→ API do web scrapingu umożliwia częste monitorowanie witryn i szybkie pozyskiwanie nowych treści.

Takie drzewo decyzji pozwala szybko dobrać narzędzie do faktycznych potrzeb – czasem w modelu łączonym.

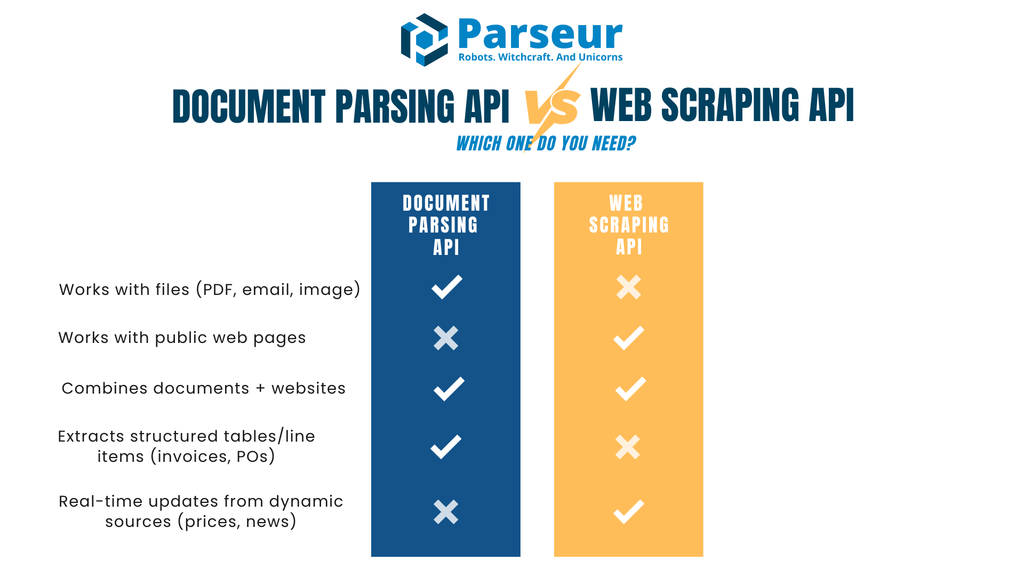

API do przetwarzania dokumentów vs API do web scrapingu – porównanie

Poniższa tabela podsumowuje najważniejsze różnice, korzyści i wyzwania obu typów API dla ekstrakcji danych:

| Kryterium | API do przetwarzania dokumentów | API do web scrapingu |

|---|---|---|

| Główne dane wejściowe | Pliki: PDF-y, skany, e-maile z załącznikami | Strony internetowe (HTML/JSON) lub renderowany DOM |

| Typowe wyniki | JSON z polami klucz-wartość, tabele pozycji, ustrukturyzowane pola | Przetworzony HTML zamieniony na JSON/CSV przy użyciu selektorów |

| Wrażliwość na zmiany | Stabilny: po ustawieniu typów dokumentów przetwarzanie jest spójne | Zmiany układu stron/DOM-u mogą łatwo wysypać selektory |

| Zastosowania | Faktury, zamówienia, umowy, formularze, wyciągi, e-maile operacyjne | Katalogi produktów, aktualizacje cen, ogłoszenia pracowe, agregacja newsów |

| Zdobycie danych | Dokumenty dostarczane przez ciebie lub użytkowników | Dane pobierane z zewnętrznych stron internetowych |

| Aspekt prawny | Prywatność i zgodność (role administratora/przetwarzającego, polityki retencji) | Regulaminy, robots.txt, ochrona antybotowa |

| Szybkość, skalowalność | Działa wydajnie w trybie wsadowym, asynchronicznym, przez webhooki | Limity crawlowania, antyboty, zarządzanie współbieżnością ograniczają możliwości |

| Utrzymanie | Rzadkie aktualizacje szablonów czy reguł | Częste dostosowanie selektorów, obsługa proxy i monitoring |

| Jakość danych | Strukturalny output, reguły walidacji, ujednolicone pola | Zmienna – zależy od jakości stron i poprawności HTML-a |

| Bezpieczeństwo | Szyfrowanie transferu i przechowywania, podpisane webhooki, kontrola dostępu | Rotacja IP/proxy, wymogi związane z bezpieczeństwem i etyką zbierania |

| Integracja z LLM | Idealny do ustrukturyzowanego JSON dla AI/ML | Świetny do pobierania tekstu do analiz i klasyfikacji |

| Kiedy wybrać | Jeśli otrzymujesz dokumenty (np. faktury, zamówienia, umowy) | Gdy potrzebujesz danych z serwisów internetowych (np. ceny, dostępność) |

Kiedy API do web scrapingu się sprawdzi – i jak korzystać odpowiedzialnie

API do web scrapingu ma przewagę, jeśli interesujące cię informacje występują wyłącznie na stronach internetowych, a nie w plikach. Pozwala pozyskiwać duże wolumeny aktualnych danych bez czekania na dokumenty od kontrahenta czy użytkownika. To narzędzie idealne do badań rynkowych, monitorowania cen, gromadzenia wiedzy czy budowania własnych baz danych w czasie rzeczywistym.

Według Browsercat, globalny rynek web scrapingu został wyceniony na 1,01 miliarda USD w 2024 r., z prognozowanym wzrostem do 2,49 miliarda USD do 2032, przy średniorocznym tempie 11,9% CAGR.

Typowe zastosowania web scrapingu obejmują:

- Monitorowanie cen i dostępności produktów w wielu sklepach internetowych

- Agregowanie newsów czy komunikatów prasowych z różnych źródeł

- Budowanie baz ogłoszeń, katalogów czy wydarzeń w sytuacji braku API

Kluczowe jest jednak odpowiedzialne stosowanie scrapingu:

- Zapoznaj się z robots.txt i regulaminem przed scrapowaniem danych

- Ograniczaj liczbę żądań, by nie przeciążać serwera

- Stosuj cache, by unikać powtarzalnych zapytań

- Identyfikuj scraper – nie ukrywaj się jako zwykły użytkownik

- Zawsze korzystaj z oficjalnych API, jeśli tylko są dostępne

Warto pamiętać, że strony często się zmieniają – nawet niewielka modyfikacja HTML może uniemożliwić prawidłową ekstrakcję danych. Konieczny jest monitoring i szybka obsługa błędów.

Nierzadko web scraping to dopiero początek procesu. Przykładowo, scraper najpierw pobiera PDF-y ze strony, a następnie są one przetwarzane przez API dokumentowe w celu uzyskania strukturalnych danych. Takie hybrydowe workflowy łączą elastyczność web scrapingu z pewnością i trwałością automatyzacji dokumentów.

Wyzwania API do web scrapingu

Chociaż API web scrapingu to skuteczna metoda na pozyskiwanie świeżych danych z internetu, napotyka pewne wyzwania i ograniczenia, które każda organizacja powinna mieć na uwadze.

Wg Octoparse, około 50% stron www jest łatwych do scrapowania, 30% wymaga zaawansowanych rozwiązań, a pozostałe 20% są wyjątkowo trudne z powodu zabezpieczeń lub złożoności.

Częste zmiany na stronach

Strony internetowe nie są projektowane z myślą o scraperach – każda zmiana struktury, class CSS lub layoutu może błyskawicznie unieruchomić scraper. To zwiększa koszty utrzymania i wymaga stałego monitorowania.

Zabezpieczenia antybotowe

Coraz więcej witryn stosuje CAPTCHA, limity IP, weryfikację sesji i inne metody ochrony przed botami. Zespoły muszą rozwijać mechanizmy obracania proxy, zarządzania user-agentami czy ograniczania częstotliwości zapytań – co podnosi złożoność i koszty projektu.

Ryzyka prawne i etyczne

Web scraping funkcjonuje w niejednoznacznym obszarze prawa. Scrapowanie publicznych danych jest czasem dozwolone, ale naruszenie regulaminu, robots.txt, czy obejście zabezpieczeń może prowadzić do odpowiedzialności prawnej. Warto opracować jasne zasady etyczne i w razie wątpliwości sięgnąć po konsultację prawną.

Jakość i spójność danych

Strony internetowe są tworzone dla ludzi, nie maszyn. Wyniki web scrapingu często wymagają gruntownego czyszczenia i walidacji, ponieważ HTML może być niespójny, dane powielone lub dynamicznie generowane przez JavaScript.

Problemy ze skalowalnością

W scrapingu na dużą skalę wyzwaniem są zarówno infrastrukturę, jak i zarządzanie kolejkami zadań, obsługa retry, monitoring błędów czy efektywne wykorzystanie proxy. Koszty utrzymania takiej platformy rosną wraz z zakresem działania.

Stabilność długoterminowa

Pipeline'y oparte na scrapingu wymagają stałej troski i dostosowywania do zmian na stronach w przeciwieństwie do stabilnych struktur plików. Należy uwzględnić nakłady czasowe na bieżące utrzymanie ekstraktora.

Kiedy API do przetwarzania dokumentów to najlepszy wybór

API do przetwarzania dokumentów okazuje się nieocenione, jeśli niezbędne dane otrzymujesz już w plikach – PDF-ach, skanach czy e-mailach z załącznikami. To rozwiązanie znakomicie automatyzuje proces przekładania nieustrukturyzowanych informacji na gotowe do użycia dane.

Według Sphereco, aż 80% danych w firmach stanowią dane nieustrukturyzowane – np. e-maile, PDF-y, obrazy – co sprawia, że przetwarzanie dokumentów jest kluczowym narzędziem do zwiększenia efektywności i jakości pracy.

Najczęstsze zastosowania to:

- Obsługa faktur i paragonów: wydobywanie nazw dostawców, kwot, dat i pozycji do automatycznych procesów płatności

- Zamówienia i wyciągi: wyodrębnianie numerów zamówień, terminów, wartości do celów rozliczeniowych

- Formularze i umowy: pozyskiwanie ustandaryzowanych danych, dat czy danych kontrahenta

- E-maile operacyjne: automatyczna konwersja informacji o zamówieniach, wysyłkach czy rezerwacjach do formatu JSON pod dalszą integrację

Przetwarzanie dokumentów pozwala nie tylko wydobyć tekst, ale także ujednolicić format, przeprowadzić walidację i przesłać dane przez webhooki od razu do Twojego systemu, co znacznie usprawnia automatyzację i analizę.

Najważniejsze jest to, że struktura plików zmienia się zwykle rzadziej niż układ stron internetowych. Raz skonfigurowane reguły pozwalają na masowe przetwarzanie tysięcy dokumentów bez konieczności ciągłych interwencji.

Dla firm regularnie obsługujących dokumenty od kontrahentów czy klientów, API do przetwarzania dokumentów jest niemal zawsze najszybszą i najtrwalszą opcją wdrożenia automatyzacji.

Hybrydowe workflowy – jak łączyć web scraping i przetwarzanie dokumentów?

W wielu przypadkach przetwarzanie dokumentów i web scraping doskonale się uzupełniają. Firmy często posiadają dane zarówno w dokumentach, jak i na stronach internetowych – ich połączenie daje maksimum korzyści z automatyzacji.

Przykładowe scenariusze hybrydowe:

- Scraping do pobrania PDF-ów, potem przetwarzanie: Scraper pobiera dokumenty z portalu dostawcy, a API do przetwarzania wydobywa z nich dane tabelaryczne do integracji.

- Wzbogacanie danych dokumentowych informacjami ze scrapingu: Najpierw przetwarzane są faktury, a następnie pobierane są dodatkowe dane (np. kategoria kontrahenta) przez scrapowanie publicznych źródeł.

- Przetwarzanie e-maili + weryfikacja danych na stronie: Szczegóły zamówień trafiają do systemu z e-maili, a scraper regularnie sprawdza ceny lub dostępność produktów bezpośrednio u dostawcy.

- Łączenie struktur dokumentów z web scrapingu: Po ekstrakcji danych z dokumentów, zasilenie ich informacjami pobranymi ze stron www umożliwia zaawansowane analizy, wykrywanie anomalii czy automatyczne kategoryzacje.

Workflowy hybrydowe pozwalają wykorzystać atuty obu podejść, minimalizując ręczną pracę i zwiększając zasięg automatyzacji danych.

Czy Parseur jest API do przetwarzania dokumentów, czy do web scrapingu?

Parseur to wydajne API do przetwarzania dokumentów i e-maili zamieniające treści nieustrukturyzowane w JSON. To nie jest narzędzie do scrapowania stron www – skoncentrowany jest na plikach i e-mailach otrzymywanych od ciebie lub twoich klientów, co zapewnia stabilność i przewidywalność automatyzacji bez komplikacji typowych dla scrapingu stron.

Parseur pozwala bez wysiłku zautomatyzować procesy związane z obsługą faktur, paragonów, zamówień, formularzy czy innych dokumentów.

Co to oznacza w praktyce

- Co robi Parseur: Przetwarza e-maile, PDF-y, obrazy i pliki biurowe, zwracając ustrukturyzowany JSON z polami klucz-wartość i tabelami pozycji – gotowy do odbioru przez webhook lub API.

- Podejście do danych: Parseur działa zgodnie z twoimi instrukcjami. Wspiera umowy powierzenia danych, ujawnia listę podwykonawców, pozwala na pełną kontrolę retencji i usuwania plików, szyfruje dane „w locie” i „w spoczynku” oraz zabezpiecza transmisje.

- Najlepsze zastosowanie: Parseur to rozwiązanie dla firm, które pozyskują dokumenty głównie przez e-mail – faktury, zamówienia, wyciągi – i chcą szybko oraz pewnie wydobywać dane do automatycznych procesów bez czasochłonnego kodowania.

Unikalne cechy Parseur API

Największym wyróżnikiem Parseur API jest połączenie integracji API z wygodną aplikacją webową. Programiści łatwo podpinają API do systemów firmowych, a operacje i wsparcie mają dostęp do panelu, gdzie mogą doglądać i korygować wyniki bez kodowania.

Nie musisz inwestować w budowę narzędzi do audytu czy zarządzania. Interfejs Parseur pozwala zdefiniować schemat JSON, obsłużyć wyjątki i walidować wyniki w kilka kliknięć – wspierając płynną pracę całego zespołu.

W odróżnieniu od scraperów uzależnionych od zmian stron www, Parseur pracuje z przewidywalnymi plikami – solidna podstawa dla skalowalnej automatyzacji.

Jak Parseur obsługuje dane?

Parseur nie jest API do scrapowania stron – zapewnia natomiast szybkie, niezawodne przetwarzanie dokumentów i e-maili dostarczanych do organizacji. Dla zespołów operujących na PDF-ach, skanach czy załącznikach Parseur gwarantuje przekształcenie plików w ustrukturyzowany JSON gotowy do dalszej automatyzacji.

Parseur kładzie nacisk na bezpieczeństwo, prywatność oraz zgodność z przepisami. Firmy korzystające z Parseur mają pewność, że ich dane są obsługiwane w pełni odpowiedzialnie i według najwyższych światowych standardów.

Najważniejsze aspekty zarządzania danymi w Parseur

Dedykacja do obsługi dokumentów i e-maili

Parseur przyjmuje PDF-y, obrazy i wiadomości e-mail, zwracając czysty JSON przez webhooki lub bezpośrednie wywołania API. To pozwala zautomatyzować procesy faktur, zamówień czy raportów bez pisania własnych parserów.

Pełna kontrola użytkownika nad danymi

Dane przesłane do Parseur pozostają wyłączną własnością klienta i są przetwarzane jedynie zgodnie z ustalonymi regułami. Ustawisz dowolny czas przechowywania plików, w tym tryb Przetwórz i usuń, który kasuje dane natychmiast po ekstrakcji.

Lokalizacja danych

Wszystkie dane Parseur przechowywane są w UE (Holandia), w centrum danych Google Cloud Platform (GCP) ze standardem ISO 27001. Szczegóły tutaj.

Bezpieczeństwo i szyfrowanie

Parseur szyfruje dane zarówno w spoczynku (AES-256), jak i w transferze (TLS v1.2+). Wycofane zostały wszystkie przestarzałe protokoły. Komunikacja chroniona jest certyfikatami Let’s Encrypt SSL.

Monitoring i pentesty

Cała infrastruktura Parseur jest monitorowana – wykryte podatności są błyskawicznie łagodzone. Niezależni audytorzy przeprowadzają regularne testy penetracyjne zgodnie z OWASP Top 10 i SANS 25. Klienci Enterprise uzyskują dostęp do raportów z pentestów. W 2025 Parseur uzyskał certyfikat Astra Pentest.

Ochrona haseł i dostępów

Parseur nigdy nie przechowuje haseł w postaci jawnej – stosowany jest algorytm PBKDF2 z SHA-256, sól 512-bitowa, 600 000 iteracji i wytyczne ponad standard NIST.

Niezawodność i SLA

Parseur gwarantuje dostępność 99,9%+ i posiada mechanizmy retry oraz backoff zapobiegające utracie danych. E-maile są powtarzane przez co najmniej 24 godziny, mechanizmy double-delivery podnoszą bezpieczeństwo procesu. Klienci Enterprise uzyskują SLA nawet 99,99%. Historia dostępności

Privacy-first & GDPR

Parseur działa całkowicie zgodnie z GDPR jako procesor danych – klient pozostaje Administratorem. Parseur nie sprzedaje ani nie udostępnia danych, a dostęp personelu odbywa się wyłącznie po prośbie i zgodzie klienta. Więcej o Parseur i GDPR

Zarządzanie incydentami i zgłaszanie wycieków

W mało prawdopodobnym przypadku wycieku, Parseur powiadamia klientów w ciągu 48 godzin, zachowując pełną przejrzystość i zgodność prawną. Dowiedz się więcej: przegląd bezpieczeństwa i prywatności Parseur

Prawo i zgodność – krótki przegląd

Aspekty prawne mają zasadnicze znaczenie przy wyborze między przetwarzaniem dokumentów a scrapowaniem stron. Oba rozwiązania wymagają legalnej podstawy, ale zakres odpowiedzialności biznesu jest inny.

Przetwarzając dokumenty, musisz mieć podstawę prawną – np. zgodę od właściciela danych, jasno zdefiniowaną rolę administratora czy procesora, podpisaną umowę powierzenia danych, politykę przechowywania, szybkie powiadamianie o incydentach i minimalizację zakresu danych.

Obszar prawny scrapingu stron bywa mniej przejrzysty. Scrapowanie ogólnodostępnych danych czasem jest zgodne z prawem, lecz wiele witryn aktywnie zakazuje tego praktyki w regulaminach i robots.txt. Omijanie zabezpieczeń, paywalla czy bot protection wiąże się z wysokim ryzykiem prawnym – zawsze skonsultuj się z prawnikiem przed masowym wdrożeniem scrapingu.

Jeśli Twoje workflowy obejmują transfery transgraniczne lub dane osobowe z UE, należy szczególnie dbać o zgodność transferu z przepisami.

Podsumowanie: które API wybrać do swoich danych?

API do przetwarzania dokumentów i API do web scrapingu oferują efektywne narzędzia automatyzacji ekstrakcji danych, jednak dedykowane są innym scenariuszom. Przetwarzanie dokumentów jest najlepsze, jeśli pracujesz z własnymi plikami – fakturami, wyciągami, e-mailami.

Zgodnie z Experlogix automatyzacja dokumentów skraca czas ich przetwarzania nawet o 80%, co obrazuje przewagę API do przetwarzania dokumentów w wielu firmach.

API do web scrapingu to odpowiedź, gdy nie masz dostępu do plików, a kluczowe dane są wyłącznie na stronach internetowych – cenniki, katalogi, oferty pracy. Często też korzysta się z obu podejść: najpierw scrapujesz, potem przetwarzasz pliki by uzyskać dane w pożądanym formacie.

Koniec końców, narzędzie dobierz do źródła danych. Jeśli dostarczane są pliki – API do przetwarzania dokumentów zagwarantuje skuteczność, dokładność i oszczędność czasu. Jeśli informacje są w sieci – postaw na scraper. Przy pracy z różnymi typami źródeł najlepsza jest strategia łączona, która kompleksowo automatyzuje cały proces pozyskania danych.

Najczęściej zadawane pytania

Wielu czytelników ma wspólne pytania dotyczące porównania przetwarzania dokumentów i web scrapingu. Poniżej znajdziesz odpowiedzi na najczęściej zadawane pytania, które pomogą wyjaśnić różnice i praktyczne zastosowania obu technologii.

-

Czy przetwarzanie dokumentów to to samo co web scraping?

-

Nie. Przetwarzanie dokumentów dotyczy plików takich jak PDF, zeskanowane obrazy czy e-maile, które już posiadasz lub otrzymałeś, natomiast web scraping polega na pobieraniu danych ze stron internetowych poprzez analizę kodu HTML lub renderowanej zawartości.

-

Czy Parseur to narzędzie API do web scrapingu?

-

Nie. Parseur to API do przetwarzania dokumentów i e-maili, a nie narzędzie do web scrapingu. Nie przeszukuje ani nie pobiera stron internetowych. Pomaga natomiast przekształcać twoje własne dokumenty – takie jak e-maile, PDF-y, obrazy czy pliki biurowe – w czysty, ustrukturyzowany JSON. Dzięki temu idealnie sprawdza się w automatyzacji takich procesów jak obsługa faktur, paragonów czy zamówień bez tworzenia skomplikowanych wewnętrznych narzędzi.

-

Czy web scraping jest legalny?

-

To zależy od kontekstu. Scrapowanie ogólnodostępnych danych jest czasami dopuszczalne, jednak witryny często nakładają ograniczenia w regulaminie lub pliku robots.txt. Zawsze sprawdź te dokumenty, a w razie wątpliwości skonsultuj się z prawnikiem przed rozpoczęciem scrapowania.

-

Kiedy unikać scrapowania?

-

Scrapowania należy unikać, gdy dane są zabezpieczone paywallem, podlegają ścisłej kontroli dostępu lub jasno zabroniono scrapingu w regulaminie witryny. Próba obchodzenia tych zabezpieczeń niesie ryzyko naruszeń zgodności oraz konsekwencji prawnych.

Ostatnia aktualizacja