Co to jest jakość danych?

Jakość danych określa, jak bardzo informacje są dokładne, kompletne, spójne i niezawodne do swojego przeznaczenia. W automatyzacji ma to ogromne znaczenie, ponieważ systemy wykonują polecenia wyłącznie na podstawie otrzymanych danych – nie sprawdzają ich poprawności samodzielnie.

Najważniejsze informacje

- Narzędzia takie jak Parseur umożliwiają skalowanie automatyzacji w oparciu o przejrzyste, zgodne z przepisami i wartościowe dane.

- Ramy jak VACUUM oraz ECCMA (Electronic Commerce Code Management Association) zapewniają strukturę umożliwiającą ocenę wiarygodności danych.

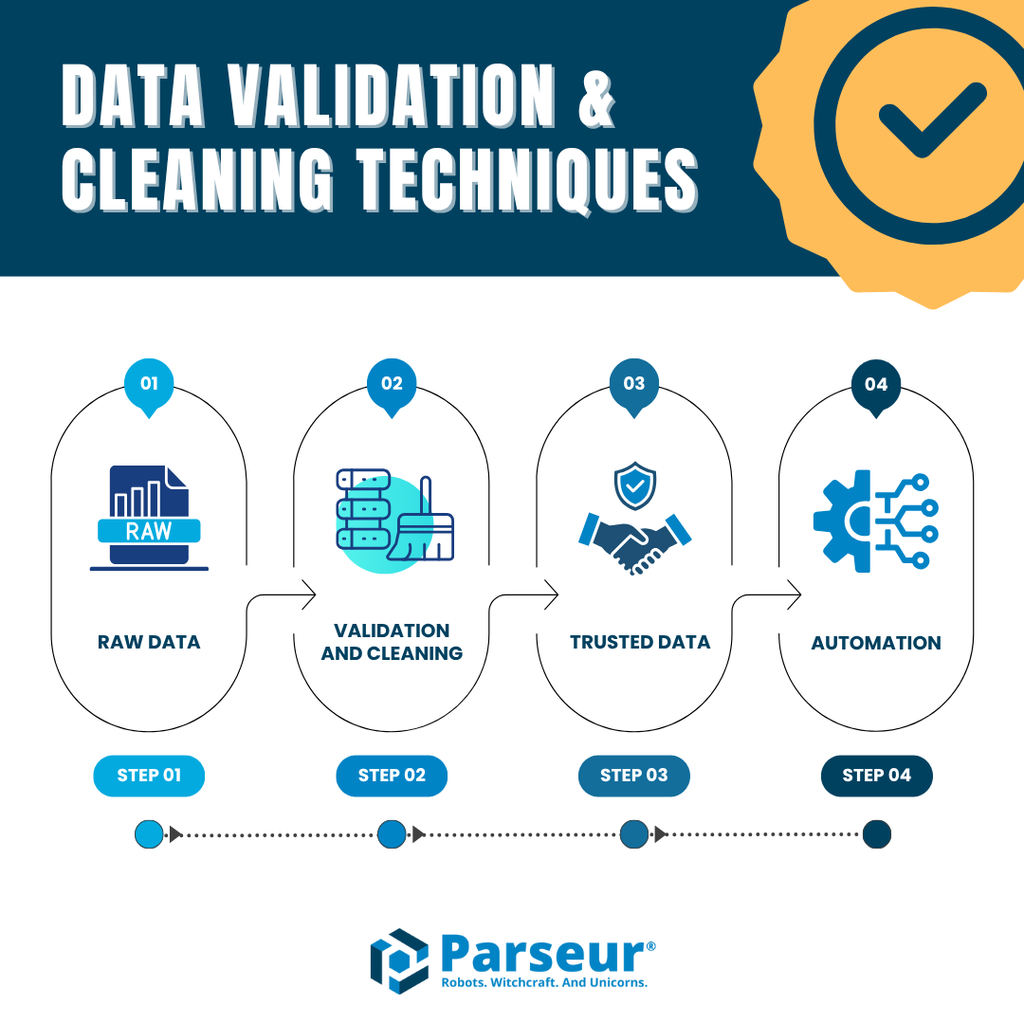

- Wykorzystanie AI, walidacji i technik czyszczenia danych wzmacnia precyzję oraz zaufanie do procesów automatyzacji.

Niska jakość danych to nie tylko niedogodność – to poważny i kosztowny problem. Badania potwierdzają, że niekompletne lub nieprawidłowe dane generują milionowe straty wynikające z marnotrawstwa zasobów, ryzyka braku zgodności oraz nietrafionych decyzji. Automatyzacja zwiększa ryzyko eskalowania tych problemów, ponieważ obowiązuje stara zasada “śmieci na wejściu, śmieci na wyjściu” (GIGO) – jeśli automatyzacja otrzyma wadliwe dane, jej rezultaty będą równie wadliwe.

Według Resolve, ręczna obróbka danych generuje błędy na poziomie 3–5%, podczas gdy automatyzacja może ograniczyć je do poziomu 0,5–1,5% oraz zmniejszyć kosztowne pomyłki nawet o 60–80% w ciągu pół roku od wdrożenia. Pokazuje to, jak automatyzacja sprzyja efektywności, ale też jak kluczowa jest dbałość o jakość danych — nawet drobne błędy, gdy skalowane, mogą powodować poważne konsekwencje. Co więcej, zła jakość danych odpowiada za 20–30% rocznych strat w przychodach, kosztując amerykańską gospodarkę 3,1 biliona dolarów rocznie, jak informuje Techment.

To właśnie dlatego jakość danych w automatyzacji jest obecnie priorytetem dla organizacji wdrażających automatyczne rozpoznawanie dokumentów czy inteligentne workflow. Wysoka jakość danych oznacza nie tylko dokładność, ale także spójność, niezawodność i zaufanie. Bez tego automatyzacja nigdy nie osiągnie swojego potencjału.

W tym artykule prezentujemy zasady zapewniania jakości danych w automatyzacji. Omawiamy ramy VACUUM i ECCMA, typowe problemy jak GIGO i sprawdzone rozwiązania oparte na AI, walidacji oraz mechanizmach HITL (Human-In-The-Loop). Po lekturze dowiesz się, w jaki sposób firmy mogą mieć pewność, że ich automatyzacja działa na rzetelnych, wartościowych podstawach.

Co to jest jakość danych?

Jakość danych oznacza, że dane są:

- Dokładne – wartości odzwierciedlają rzeczywistość (np. kwota na fakturze zgadza się z należnością).

- Kompletne – żadne istotne pole nie jest pominięte (np. w umowie zawsze występuje data początkowa i końcowa).

- Spójne – te same informacje są jednakowe w wielu systemach (np. identyfikatory klientów są takie same w CRM i ERP).

- Niezawodne – dane są aktualne i pochodzą ze sprawdzonych źródeł.

Kiedy automatyzacja operuje na wysokiej jakości danych, procesy działają płynnie, decyzje są trafniejsze, a błędy rzadko się zdarzają. Złe dane natomiast prowadzą do powielanych błędów, utraty zgodności i nieprawidłowych analiz — wszystkie te problemy mogą się gwałtownie nasilić w zautomatyzowanych systemach.

Podsumowując: jakość danych w automatyzacji gwarantuje, że każda automatyczna operacja bazuje na informacjach, którym można zaufać. Bez niej nawet najlepiej zaprojektowane systemy AI czy machine learning nie przyniosą oczekiwanych efektów.

Dlaczego jakość danych jest istotna w automatyzacji obiegu dokumentów

Jakość danych nie jest jedynie zagadnieniem technicznym. To fundament przewagi konkurencyjnej. Automatyzacja oparta na słabych danych rzutuje na wyniki całego biznesu.

Wydajność

- Niedokładne dane spowalniają wykonywanie zadań automatycznych.

- Ręczna korekta błędów bywa kosztowna i pracochłonna.

Koszt

- Zgodnie z MIT Sloan, zła jakość danych pochłania przeciętnie 15–25% przychodów organizacji wskutek marnotrawstwa zasobów i nieefektywności.

- W środowiskach zautomatyzowanych błędy szybko się utrwalają i powielają.

Zgodność z przepisami

- Błędnie przetworzone dokumenty (np. faktury czy formularze medyczne) mogą powodować naruszenia prawne, kary i odpowiedzialność.

Zaufanie klientów

- Klienci nie będą ufać firmie, która generuje omyłkowe faktury, błędnie rejestruje zgłoszenia czy gubi istotne szczegóły przesyłek.

W automatyzacji ryzyka te rosną wykładniczo. Złe dane nie tylko zalegają w bazie – przepływają przez systemy w ogromnych ilościach. Zamiast wzmacniać efektywność, mogą powodować drogie korekty i straty, potwierdzając zasadę Garbage In, Garbage Out.

Model VACUUM: struktura oceny jakości danych

Model VACUUM to uznany wzorzec służący do oceny jakości danych. Obejmuje sześć kluczowych wymiarów, które determinują przydatność informacji w procesach zautomatyzowanych. W praktyce model VACUUM stanowi niezbędną checklistę pozwalającą sprawdzić, czy wyciągnięte dane rzeczywiście nadają się do dalszego użytku.

Wymiary VACUUM:

- Valid (Ważność) – Czy dane mają prawidłowy format i spełniają określone reguły? Przykład: data na fakturze wpisana w poprawnej formie, a nie jako przypadkowy ciąg znaków.

- Accurate (Dokładność) – Czy dane odzwierciedlają rzeczywistość? Numer pacjenta na formularzu musi się zgadzać z danymi w systemie.

- Consistent (Spójność) – Czy te same informacje są identyczne w różnych systemach? Nazwa kontrahenta powinna być taka sama na wszystkich dokumentach.

- Uniform (Jednolitość) – Czy unikamy powielania tych samych wpisów? Np. dokument wysyłkowy powinien być przetwarzany wyłącznie raz.

- Unified (Ujednolicone) – Czy jednostki, waluty i formaty są konsekwentne? Wszystkie kwoty muszą być np. podane w tej samej walucie.

- Model (Znaczenie) – Czy dane mają wartość dla danego procesu? Wyciąganie przypadkowych pól niepotrzebnych w workflow nie ma sensu.

W przypadku automatycznej ekstrakcji danych – np. z faktur, dokumentów medycznych lub listów przewozowych – model VACUUM gwarantuje, że zebrane dane będą nie tylko cyfrowe, ale również użyteczne i wiarygodne.

Wyzwania w zapewnianiu jakości danych w automatyzacji

Nawet najlepsze technologie nie eliminują wszystkich barier związanych z jakością danych. Jak wynika z globalnego badania Precisely z 2025 r., dla 64% firm jakość danych jest największym wyzwaniem, a 67% przedsiębiorstw nie ufa w pełni swoim danym przy podejmowaniu decyzji biznesowych. Ta luka pokazuje, że efektywna automatyzacja wymaga solidnych danych, a nawet najinteligentniejsze algorytmy mogą zawieść na słabym fundamencie.

To realny problem. Na przykład, raport Monte Carlo opisuje przypadek rynku frachtowego, który przez wadliwe dane w systemie automatyzacji poniósł milionowe straty: błędne prognozy, setki incydentów, tysiące godzin na naprawy i ostateczne zamknięcie działalności.

Najpopularniejsze wyzwania w automatyzacji

- Niestrukturalne dane → Faktury, umowy, paragony i formularze występują w rozmaitych formatach, językach i układach, co utrudnia wydobycie właściwych informacji.

- Błędy ludzkie → Literówki, braki, niejednoznaczne oznaczenia – wszystko to może ciągnąć się przez cały zautomatyzowany proces.

- Problemy przy skalowaniu → Rozwiązanie skuteczne przy 100 dokumentach może zawieść przy 100 000, gdyż drobne odstępstwa rosną do rangi poważnych błędów.

- Brak automatycznych walidacji → Bez mechanizmów kontroli nie wykryjemy nieprawidłowych numerów, kwot czy dat.

Garbage In, Garbage Out (GIGO)

Te wyzwania prowadzą do klasycznej zasady Garbage In, Garbage Out (GIGO). Jeśli do systemu trafiają błędne dane, wynik takich procesów również będzie błędny. Automatyzacja nie naprawia złych danych – raczej je powiela.

Przykłady GIGO w automatyzacji dokumentów:

- Niestrukturalne, chaotyczne pliki – Skanowane PDF-y, ręcznie wypełniane formularze, niestandardowe faktury utrudniają precyzyjną ekstrakcję danych.

- Błędy w źródle – Jedna literówka w numerze faktury lub ID klienta to potencjał dla poważnych rozbieżności, np. w płatnościach i wysyłkach.

- Niespójne dane – Różne formaty dat, walut, jednostek dezorganizują dalszy automatyczny przepływ informacji.

- Skalowanie błędów – Jeden błąd ręcznie można skorygować, ale w zautomatyzowanej skali nawet drobna pomyłka niesie poważne skutki i koszty.

Życiowe przykłady:

- Faktury: Moduł OCR rozpoznaje „1 249,99 $” jako „12 499,9 $”. Brak walidacji sprawia, że błędna kwota trafia do księgowości, generując fałsz.

- Formularze medyczne: Słaba jakość obrazu skutkuje złym ID pacjenta, co prowadzi do dokumentacyjnych nieścisłości i potencjalnych problemów prawnych.

- Dokumenty wysyłkowe: Rozmazany kod kreskowy może oznaczać błędy adresowe, skutkując opóźnioną lub zagubioną przesyłką.

Wniosek: bez ścisłej kontroli jakości, automatycznej walidacji, czyszczenia i przeglądu HITL automatyzacja może nie tylko utrwalać, ale wręcz wzmacniać błędy, generując straty finansowe i wizerunkowe.

Standardy ECCMA i ISO 8000: globalna jakość danych

Kwestia jakości danych w automatyzacji nie ogranicza się do modeli teoretycznych – potrzebne są także powszechnie uznane standardy, które ułatwiają jednolitość, zgodność i interoperacyjność w różnych branżach oraz na rynkach międzynarodowych.

Przykładem jest Electronic Commerce Code Management Association (ECCMA), która opracowuje międzynarodowe standardy jakości danych, w tym ISO 8000. Standard ten wyznacza dobre praktyki w zakresie tworzenia, zarządzania i przekazywania wysokiej jakości danych referencyjnych pomiędzy systemami. W automatyzacji stanowi gwarancję, że dane są nie tylko możliwe do odczytu przez maszyny, ale także semantycznie zgodne i globalnie operacyjne.

Kluczowe zalety korzystania ze standardów ECCMA w automatyzacji:

- Spójność pomiędzy systemami → ECCMA zapewnia płynny przepływ danych z dokumentów do systemów ERP, CRM czy księgowości, eliminując niezgodności.

- Dokładność i niezawodność → Klarowne reguły formatowania i struktury eliminują kosztowne pomyłki i nieporozumienia.

- Zgodność i gotowość do audytu → Międzynarodowe standardy ułatwiają spełnienie wymogów regulacyjnych — szczególnie ważne w branżach jak finanse, zdrowie czy logistyka.

Przetwarzając fakturę według standardu ECCMA, system nie tylko odczytuje „wartość ogółem”, ale również poprawnie ją mapuje do systemu finansowego lub księgowego.

Parseur bazuje na tych dobrych praktykach, łącząc AI-powered extraction z normalizacją i walidacją, co umożliwia tworzenie workflow opartych na czystych, zgodnych danych.

VACUUM vs ECCMA – różne podejścia do jakości danych

| Czynnik | Model VACUUM | Standardy ECCMA |

|---|---|---|

| Zakres | Ramy koncepcyjne do oceny jakości danych. | Międzynarodowe standardy tworzenia, zarządzania i wymiany wysokiej jakości danych (ISO 8000). |

| Przeznaczenie | Ocena, czy dane są przydatne do użycia. | Globalnie rozpoznawalne reguły interoperacyjności i zgodności. |

| Zaleta | Elastyczny, łatwy do stosowania w wielu branżach i workflow. | Zapewnia standaryzację w systemach i na całym świecie. |

| Zastosowanie w automatyzacji | Ocenia, czy dane wyekstrahowane z faktur, formularzy czy umów spełniają wymogi jakości. | Zapewnia, że dane mają uniwersalny format, rozpoznawany przez systemy downstream. |

Wykorzystanie AI do zapewnienia jakości danych – inteligentna walidacja i usprawnianie ekstrakcji

Sztuczna inteligencja zmienia podejście do zapewniania jakości danych w automatyzacji. Tradycyjne metody, takie jak ręczne sprawdzanie czy walidacja regułowa, są skuteczne na małą skalę, ale nie sprawdzają się w dużych projektach. AI umożliwia elastyczność, samodoskonalenie i szybkie skalowanie.

Jak AI wpływa na jakość danych:

- Walidacja kontekstowa – AI rozumie kontekst danych i wychwytuje nietypowe błędy, jak niepasujące daty czy niewłaściwe waluty.

- Automatyczne rozpoznawanie jednostek danych – Algorytmy ML skutecznie identyfikują konkretne pola, nawet w trudnych, nieustrukturyzowanych dokumentach.

- Wykrywanie i naprawa błędów – AI wykrywa anomalie, np. nieprawidłowy podatek lub sumę, i automatycznie proponuje poprawki.

- Ciągły samorozwój – Systemy AI poprawiają się dzięki informacjom zwrotnym, zwiększając skuteczność wraz z upływem czasu.

- Obsługa wielu języków – AI ułatwia ekstrakcję danych w wielu językach i alfabetach — sprawność działania globalnego workflow.

Wnioski? AI nie tylko zautomatyzowało „czytanie” dokumentów – aktywnie podnosi jakość, wiarygodność i spójność danych, będąc niezbędnym wsparciem dla automatyzacji na dużą skalę.

Walidacja i czyszczenie danych w praktyce

Aby utrzymać jakość danych w automatyzacji, niezbędne są nie tylko precyzyjne ekstrakcje, ale i regularna walidacja oraz czyszczenie. Nawet najlepszy OCR lub AI nie wystarczy, by zatrzymać wszelkie błędy u źródła.

Najważniejsze techniki zapewnienia jakości:

- Automatyczna walidacja pól – Kontrola formatów (np. liczby, daty, schematy identyfikacyjne), by wyodrębnione wartości były zgodne z założeniami systemu.

- Wykrywanie duplikatów – Eliminacja powtarzalnych rekordów, by uniknąć nieporozumień i nadmiernego obciążenia workflow.

- Normalizacja – Ujednolicanie wartości (daty, waluty, adresy, numery telefonów), by wszędzie występowały w spójnej, przetwarzalnej postaci.

- Oznaczanie wyjątków – Wyłapywanie nietypowych przypadków (braki czy błędne sumy), zanim dane trafią do systemów downstream.

- Kontrola HITL (Human-in-the-loop) – Przypadki graniczne trafiają do inspekcji ludzkiej, co zapewnia precyzję bez rezygnacji z zalet automatyzacji.

Parseur oferuje te funkcje natywnie, łącząc ekstrakcję bez szablonów, walidację i płynne integracje z ERP, CRM czy księgowością. Dzięki temu automatyzacja opiera się nie na losowych, ale na uporządkowanych, poprawnych i wartościowych danych.

Więcej znajdziesz w naszych przewodnikach na temat walidacji danych oraz technik czyszczenia danych: dowiedz się, jak te metody usprawniają automatyzację w praktyce.

Jak Parseur gwarantuje wysoką jakość danych

W celu zapewnienia jakości danych w automatyzacji Parseur wdraża efektywne, sprawdzone rozwiązania. Zamiast polegać wyłącznie na OCR czy szablonach, Parseur wykorzystuje AI do ekstrakcji danych, automatyczną walidację i płynne integracje z innymi narzędziami. Dzięki temu uzyskujesz dane, które dokładnie odpowiadają Twoim wymaganiom i procesom biznesowym.

Najważniejsze funkcje Parseur podnoszące jakość danych:

- Ekstrakcja bez szablonów – Działa z wieloma typami dokumentów (faktury, paragony, umowy, listy przewozowe), dopasowując się do zmiennych układów bez konieczności budowy osobnych reguł.

- Skuteczność ekstrakcji – Parseur osiąga precyzję nawet 90–99% na poziomie pojedynczych pól, niezależnie od rodzaju czy układu dokumentu.

- Wbudowana walidacja i czyszczenie – System samodzielnie wykrywa duplikaty, błędy formatu i anomalie, dostarczając dane gotowe do dalszego przetwarzania.

- Gotowość do integracji – Dane trafiają bezpośrednio do Google Sheets, baz SQL, ERP, CRM czy systemów finansowych, eliminując konieczność dodatkowego przetwarzania.

Praktyczny wpływ

- W finansach: Parseur pozwala automatycznie wyciągać kwoty, identyfikatory i dane płatnicze z faktur, zmniejszając udział pracy ręcznej nawet o 80%.

- W logistyce: ekstrakcja ID przesyłek i adresów z listów przewozowych i potwierdzeń odbioru minimalizuje pomyłki i przyspiesza proces.

Dzięki wdrożeniu modeli VACUUM oraz standardów ECCMA, Parseur pozwala automatyzować przetwarzanie dokumentów nie tylko szybciej, ale i z gwarancją zgodności oraz wysokiej jakości.

Podsumowanie

Automatyzacja zapewnia szybkość działania, skalowalność i efektywność – pod warunkiem, że opiera się na czystych, spójnych i niezawodnych danych. Przedstawione modele, standardy oraz techniki walidacji i czyszczenia gwarantują, że dane przynoszą prawdziwe korzyści: ograniczają koszty, zwiększają zaufanie i minimalizują ryzyka.

Ostatecznie każda automatyzacja jest tak skuteczna, jak dane za nią stojące. Inwestując w ich jakość, firmy budują podstawę pod szybkie i bezpieczne decyzje biznesowe oparte na automatyzacji.

Wybierając Parseur, otrzymujesz automatyzację gwarantującą dokładność, niezawodność i zgodność z uznanymi na całym świecie standardami. Niezależnie czy chodzi o faktury, dokumentację medyczną czy logistykę, Parseur to pewność, że Twoje procesy opierają się na danych jakościowych najwyższej klasy.

Najczęściej zadawane pytania

Zapewnienie jakości danych w automatyzacji to złożone, ale kluczowe zadanie. Firmy często pytają, jak ramy, standardy i narzędzia współdziałają, by utrzymać precyzję i wiarygodność automatyzacji. Poniżej znajdują się odpowiedzi na najczęstsze pytania:

-

Czym jest jakość danych w automatyzacji?

-

Jakość danych w automatyzacji odnosi się do dokładności, spójności i niezawodności danych przepływających przez zautomatyzowane systemy. Wysokiej jakości dane gwarantują płynność procesów, natomiast słabe dane prowadzą do błędów, nieefektywności oraz ryzyka niezgodności.

-

Dlaczego jakość danych jest ważna w automatyzacji?

-

Automatyzacja opiera się na wejściowych danych do podejmowania decyzji. Jeśli dane są wadliwe, automatyzacja zwielokrotnia błędy na dużą skalę. Dbałość o jakość danych obniża koszty, zwiększa efektywność i buduje zaufanie do automatycznych procesów.

-

Czym jest model VACUUM w kontekście jakości danych?

-

Model VACUUM definiuje sześć kluczowych wymiarów jakości danych: Ważność (Validity), Dokładność (Accuracy), Spójność (Consistency), Unikalność (Uniqueness), Jednolitość (Uniformity) i Znaczenie (Meaningfulness). Stanowi ramy oceny, czy wyekstrahowane dane są godne zaufania i przydatne w automatyzacji.

-

Czym są standardy jakości danych ECCMA?

-

ECCMA opracowuje globalne standardy jakości danych, takie jak ISO 8000. Standardy te zapewniają spójność danych, interoperacyjność i zgodność branżową, czyniąc wyniki automatyzacji bardziej niezawodnymi i gotowymi na audyt.

-

Jak firmy mogą poprawić jakość danych w automatyzacji?

-

Przedsiębiorstwa mogą podnieść jakość danych przez walidację, czyszczenie, normalizację, wykrywanie duplikatów oraz przegląd z udziałem człowieka. Narzędzia oparte na AI, jak Parseur, upraszczają te kroki, zapewniając automatyzację opartą na precyzyjnych i użytecznych danych.

-

Jak Parseur zapewnia jakość danych?

-

Parseur stosuje ekstrakcję wspieraną AI, wolną od szablonów, z wbudowaną walidacją, czyszczeniem oraz integracjami. Działa w zgodzie z najlepszymi praktykami, takimi jak VACUUM i ECCMA, dostarczając dokładną, niezawodną i skalowalną automatyzację dla firm z różnych branż.

Ostatnia aktualizacja