データ検証は、情報がデータベースに登録される前に「正確で利用に耐えうるものか」を確認する重要なプロセスです。正確なデータは意思決定の根幹であり、信頼性の低いデータは企業に高コストの失敗をもたらします。たとえば誤った請求書、不適切な決算報告、間違った戦略選択などです。Gartnerによれば、データ品質の低下は企業の平均年間1,290万ドルという巨額損失の要因に。

不十分なデータの最大要因の一つは、入力時に十分な検証がなされていないことです。必要なチェックがないと、重複・フォーマット不一致・必須項目の抜けといったミスが見逃され、非効率化や経済的な損失を招きます。

本ガイドではデータ検証がなぜ必要なのか、またデータ入力ソフトウェアでどのように実践できるかを分かりやすく解説します。ありがちな理論解説だけでなく、最新のデータ入力ソフトウェアでの活用ノウハウも紹介します。

主なポイント:

- データ検証は、データが保存・処理される前に「正確さ」「完全性」「一貫性」を保証します。

- 粗悪なデータ品質は、企業に年間数百万ドルの損失や業務ミス・コンプライアンスリスクをもたらします。Gartnerは不十分なデータによる平均年間損失を1,290万ドルと推計。

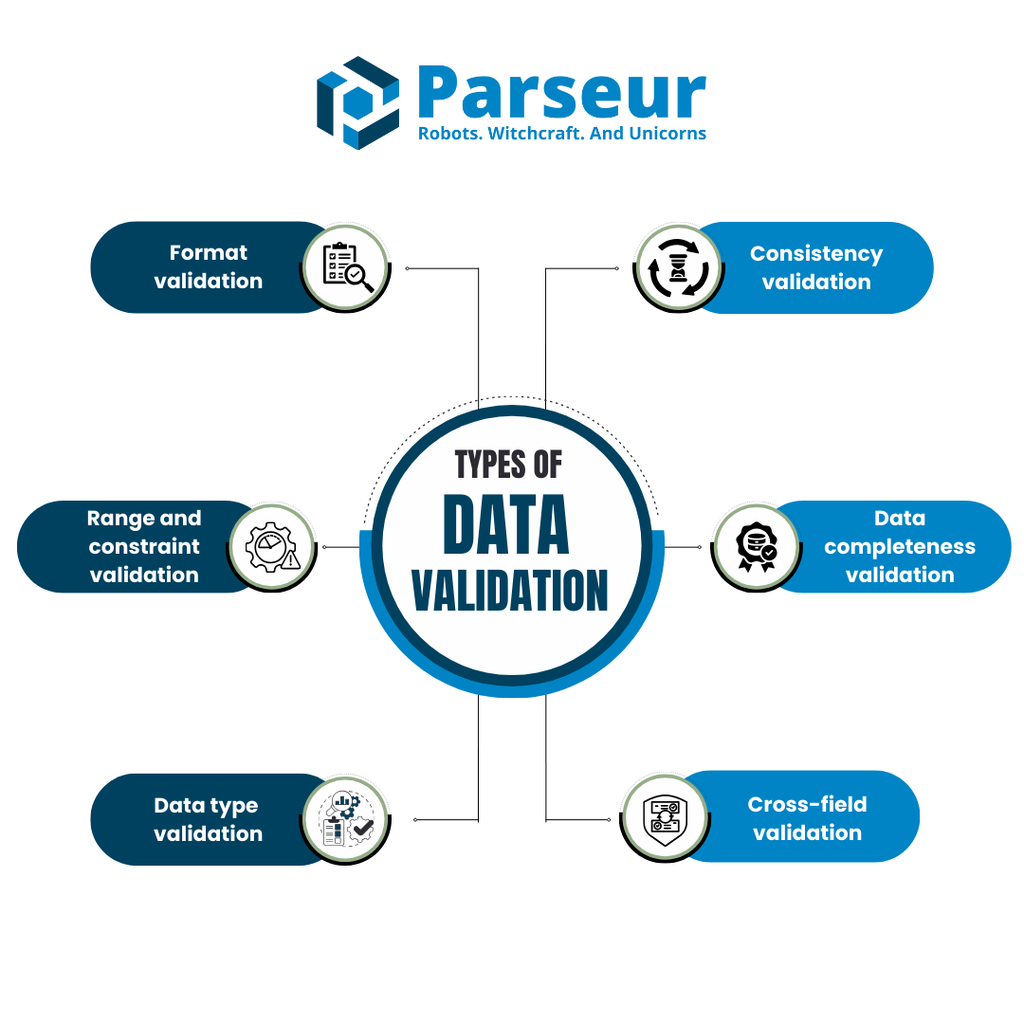

- フォーマットチェック、範囲・制約、一貫性、クロスフィールド、データ型、許可値制約など多様な検証タイプがあります。

データ検証とは?

データ検証とは、データをシステムやデータベースに登録する前に、正確性・完全性・あらかじめ定められた基準を満たしているかを確認するプロセスです。主目的は、収集した情報が「正しいか」「一貫しているか」「信頼できるか」を保証すること。代表的な手法として、フォーマット検証(例:指定形式での入力)、一貫性検証(複数フィールドの論理整合)、完全性検証(必須項目入力の確認)などがあります。

データ検証の基本はExcelのような表計算ソフトに限定されません。企業向けのデータ入力ソフトウェアやシステムでも、データベースの健全性確保に幅広く応用されています。

データ検証の種類

正確で信頼できる情報を維持するため、企業は様々な検証手法でデータの健全性維持に努めています。代表的な手法は以下の通りです。

1. フォーマット検証

データが所定の形式に従っているかを確認します。例:

- 電話番号の桁数が正しいか

- 日付が標準フォーマット(MM/DD/YYYYやDD/MM/YYYY)で記述されているか

- メールアドレスに「@」とドメイン名が含まれているか

2. 一貫性検証

関連データ間の整合性チェック。

- 顧客住所と郵便番号の対照

- 注文詳細が在庫と一致しているか

- 従業員データが複数システムで矛盾なく保たれているか

3. 範囲・制約検証

数値や日付などが許容範囲内かの確認。例:

- 従業員年齢がマイナスになっていないか

- 割引率が100%を超えない

- 売上金額が妥当な範囲内か

4. データ完全性検証

必須フィールドがすべて入力されているか。

- 配送先住所がないと注文不可

- ユーザー登録フォームでメール・パスワード必須

5. クロスフィールド検証

複数項目間の論理的な整合性を確認。

- 旅行予約で出発日が帰着日より前であること

- 請求書の合計金額がアイテムごとの合計と一致

6. データ型検証

- 入力値が所定の型(文字列、整数、日付など)でなければ却下される(例:電話番号欄に文字なら不可)。

データ検証のプロセス

フォーム入力・スプレッドシート・自動データ取込など、どんな場合にも下記のフローが適用されます。

1. データ要件(基準)の定義

まず各フィールド/セットごとに「有効」なデータの基準を定義します。許容フォーマット(例:日付はYYYY-MM-DD)、必須項目、値範囲、フィールド間依存など。

2. 検証ルールの策定

要件に基づき明確なルールを設定。

- フォーマットチェック(例:メールは「@」を含む)

- 範囲チェック(例:請求額は0より大きい)

- 完全性チェック(例:必須フィールドはNULL禁止)

- データ型チェック(例:数量は数値)

- クロスフィールド検証(例:「終了日」は「開始日」より後)

3. ワークフローへの実装

データ入力ソフトや自動化ツールで、これらのルールを直接フォームやテンプレート、抽出フローに組み込みます。自動化によって一貫したルール適用・手作業の排除ができます。

4. サンプルデータによるテスト

運用開始前にサンプルケースでルール機能を確認。正しいデータと意図的に不正なデータの両方をテストし、誤検知や正当なデータのブロックが起きていないか点検します。

5. 継続的なモニタリングと改善

データ要件は変化し続けます。エラーログ・ユーザーからの声・出力データを監視し、定期的にルールをチューニングしましょう。環境が複雑な場合はバージョン管理導入も有効です。

データ検証は幅広いデータガバナンスの柱でもあり、ISO 8000シリーズなど国際標準でも推奨されています。これにより、正確性・履歴追跡・一貫性・将来の維持管理までが重視されます。

AIによるデータ検証の役割

データ量が増大し業務システムが複雑化する中、従来の検証法だけでは限界も見えています。

1. インテリジェントなルール自動生成

AIは過去データから異常検出やパターン把握を自動化し、賢い検証ルールづくりを強力にサポート。たとえば領収書や請求書のパターンを学習し、しきい値や例外判定を自動推奨・検知します。

2. コンテキスト理解

静的ルールと違い、AIは文脈も理解。自然言語処理(NLP)を使えば非構造化・半構造化の文章や手書きの住所、メール本文データなども検証対象にできます。

3. リアルタイム異常検出

AIシステムはデータが蓄積されるたび自己学習し、リアルタイム検証が可能。同時進行の入力でも、重複や誤区分、不審な金額の異常を即検出します。

4. 人手作業の削減

AI駆動ツールの活用により、従来必要だった数十個の手作りルールを減らせます。チームは予測モデルや賢いフローに託し、効率と精度を両立できます。

5. 大規模でも高精度維持

膨大なデータ件数でもAIは高品質検証を実現。たとえば物流・保険・金融業界のような大量処理現場でも、数百万件規模を高速処理し、ボトルネック削減や規制遵守に寄与します。

手動 vs 自動データ検証

| 基準 | 手動データ検証 | 自動データ検証 |

|---|---|---|

| 速度 | 遅く、手間がかかる | 高速かつ大規模対応可能 |

| 正確性 | 人的ミスが発生しやすい | 高精度 |

| スケーラビリティ | データ量が増えるほど困難 | システム・複数データセットに容易に拡張可能 |

| 複雑なデータ対応 | 非構造・複雑データは不向き | 構造化/半構造化/非構造化データにも柔軟 |

| リアルタイム検証 | ほぼ不可 | 入力時リアルタイムに即時対応可能 |

| 保守・アップデート | ルールの変更はコード修正・レビューが必須 | AIがパターン学習し自動チューニング |

| 長期コスト | 人件費が膨らむ | 長期的にはコスト低減 |

小規模ならExcelやGoogleスプレッドシート等の入力規則でも十分ですが、規模が大きくなる場合は専用入力ソフトやデータベース制約が不可欠です。

データ入力ソフトでのデータ検証

自動化されたデータシステムによる精度の高い検証は、データの品質と正確性向上に直結します。現代的なデータ入力ソフトは、入力工程の中でシームレスに検証を組み込み、データが記録・利用される前に基準適合を担保します。

データ品質が悪い場合、主な結果は次の通りです:

- 不正確なレポート:誤ったデータ起因のレポートで経営判断が誤導される場合があります。

- 判断ミス:間違った情報に基づけば戦略や日常運用で重大な判断ミスを生みます。

- コスト増:誤りの修正や再作業で追加リソースが発生し、経費がかさみます。

Gartnerの調査では、年間平均1,500万ドルの損失がデータ品質の低さに起因するとのことです。

- 顧客満足度低下: 顧客情報の誤りは配送ミスやサービス低下に繋がり、ブランド評価の毀損リスクとなります。

Experian発表では、91%の企業が誤データによる機会損失・効率低下に直面しています。

効果的なデータ検証の主なメリット

堅実な検証を導入することで、次のような利点があります:

- 意思決定の正確性向上

検証済みデータのおかげで、意思決定者は信頼できる情報に基づき行動できます。データの一貫性・正確性・完全性が担保され、戦略判断も正しくなります。

- 運用効率アップ

検証作業自動化によって、従業員がより付加価値の高い仕事に集中できます。システム内にエラーが持ち込まれる前に摘み取ることで、再作業や業務停滞を未然に防止します。

- エラー・コストの削減

精度の高いデータはシステムトラブルの大幅減につながります。エラー対応にかかる金銭・時間リソースも削減でき、事業全体のリソース配分が最適化されます。

- 顧客信頼・満足度の向上

正しい顧客データによりサービスや連絡・取引ミスが減少し、顧客体験やブランド信頼アップに貢献します。

データ検証のユースケース例

業界によって求められる検証内容は様々ですが、本質は「信頼できる情報の担保」です。

- 医療:患者IDと生年月日で個人情報を照合し、適切なカルテを参照。投薬指示では用量・単位の検証で投薬ミスを予防します。

- 金融:銀行や金融サービスでは、取引データや顧客情報の検証・規則適用により法規制遵守や不正防止を実現。口座番号の入力ミスもチェックサムで取引前に弾けます。

- 小売/EC:配送先郵便番号と市町村名の一致検証で誤配送を低減。在庫・価格情報の検証で顧客の画面情報が正確最新かを維持。

- 教育:履修登録時、必修科目の履修確認ルール(例:「微積分I」未履修の学生は「微積分II」に申込不可など)で条件未達の登録を自動排除。

データ検証の失敗例と回避策

データ正確性・信頼性を守るこのプロセスも、典型的な失敗で効果減となる場合があります。主な失敗と回避策は下記の通りです:

- 検証ルールを複雑化しすぎる

必要以上に複雑なルールは業務を遅らせ、入力現場に負担をかけます。全項目を必須にしすぎたり制約が多すぎると、ユーザーのストレスや処理遅延に直結。

回避策:

本当に必要な項目・ルールに絞りシンプルに。現状業務と合致しているか定期見直し。

- 定期見直しの怠り

業務・データ要件が変化してもルールを放置すると、現状と乖離した陳腐な検証でエラーや漏れが発生。

回避策:

新しいデータや業務要件に対応できるようルールは定期的にアップデート。ギャップ把握のためモニタリングツールも併用。

- 自動化の未活用

手動検証は労力・時間がかかり大量データには適していません。

回避策:

自動検証を徹底。典型的なフォーマット・抜けデータをトリガー検証で即修正する仕組み作り。

- 外部データソースの見落とし

外部データは誤りやフォーマットの違いが多く、検証漏れで品質低下のリスクも。

回避策:

外部ソースも検証範囲に入れ、フォーマット・完全性を自動チェックする統合ツールを導入。

- テストを省略

十分な検証テストをせず導入すると、現場運用で予期せぬトラブルが頻発。

回避策:

本番前にサンプルデータでルールが想定通りか検証。実装前の問題洗い出しで品質トラブルの芽を摘みます。

入力後のデータベースにエラーやクレンジング作業が多いなら、その検証プロセスは改善余地ありのサイン。典型的ミスを避け、高効率で信頼性あるデータ体制を構築しましょう。

よくある質問

データ検証に関してよく寄せられるご質問と回答をまとめました。

-

ワークフローにデータ検証を手軽に組み込むには?

-

最も簡単なのは、検証機能付きのデータ入力ツールを活用することです。優先度の高いフィールドを特定し、日付形式やメールアドレスなどの基本的なフォーマット検証ルールを設定しましょう。自動化することでヒューマンエラーを減らし、作業効率も向上します。

-

自動データ検証で手動チェックは不要になる?

-

データ自動検証により手動チェックの多くは不要になりますが、完全に置き換わるわけではありません。自動化はフォーマットや完全性、一貫性の検証には非常に有効ですが、複雑・主観的なケースや高度な判断が求められる場合は、依然として人による確認が必要となり得ます。

-

データ検証はコスト高・維持が大変?

-

自動化ツールを使えば、データ検証はコスト効率がよく維持も容易です。ほとんどの自動データシステムには標準機能として検証が用意されており、大がかりな保守作業を必要としません。エラーを未然に防ぎ、手作業負担や長期的な維持コストを抑えることができます。

-

データ検証(バリデーション)とデータ検証(ベリフィケーション)は何が違う?

-

これらは関連しつつも明確に異なる概念です。バリデーションは、誤ったデータがシステムに入るのを防ぐため、入力時点でルールを適用する「予防」です。一方、ベリフィケーションは入力後に信頼できる情報源との照合や2重データ入力などで正確性を「確認」する工程。両者はデータ品質を支えるため併用されますが、バリデーションが第一防御、ベリフィケーションがその後の抜け漏れ発見の役割を果たします。

-

Excelやデータベースのデータ検証例は?

-

Excelでは「データの入力規則」機能でセルごとに入力値の型や範囲(例:1~100の整数のみ/必須項目に空欄不可など)を制限できます。データベースでは、スキーマやアプリケーションレベルでデータ型・NOT NULL制約・外部キー制約などを用いて検証を実施します。

-

Garbage In, Garbage Out(ゴミを入れたらゴミが出る)とは?

-

「Garbage In, Garbage Out(GIGO)」は、「不正確なデータを入力すれば、不正確な結果しか得られない」というITの基本原則です。

-

入力値検証とは?

-

入力値検証は、ユーザーやシステムが入力・取得したデータが処理や保存の前に正確性・完全性・規定フォーマットを満たしているかをチェックするプロセスのことです。

最終更新日