핵심 요약

- 데이터 추출 결과는 설계에 따라 지저분하게 나와 검증과 후처리가 필요합니다.

- 신뢰성 있는 파이프라인을 위해서는 스키마 검증, 정규화, 텍스트 정리, 테이블 수정, 중복 제거, 지속적인 QA 점검이 필수입니다.

- JSON Schema, Pydantic, Pandas, Great Expectations 등 다양한 도구로 후처리를 자동화하고 효율적으로 만들 수 있습니다.

- Parseur API를 활용하여 데이터를 빠르게 정형화하면 품질 관리와 분석 준비에 집중할 수 있습니다.

데이터 정제 기법은 API에서 반환된 원시 데이터를 올바르게 수정, 표준화, 검증하는 과정을 뜻합니다. 추출 도구를 활용하면 PDF, 이미지, 이메일과 같은 비정형 파일을 JSON이나 CSV 등 정형 포맷으로 바꾸지만, 여전히 일관성 없는 값, 결측치, 잘못된 타입, 중복, 서식 오류 등이 포함될 수 있습니다. 정제를 통해 데이터셋이 원하는 스키마에 맞고, 보고·분석·후속 업무에 신뢰할 수 있게 만듭니다.

최근 DataXcel의 사례 연구는 추출된 전화 기록의 14.45%가 무효 또는 비활성임을 밝혀, 강력한 데이터 정제 관행의 중요성과 추출 데이터 품질 확보의 필요성을 다시 한번 보여줍니다.

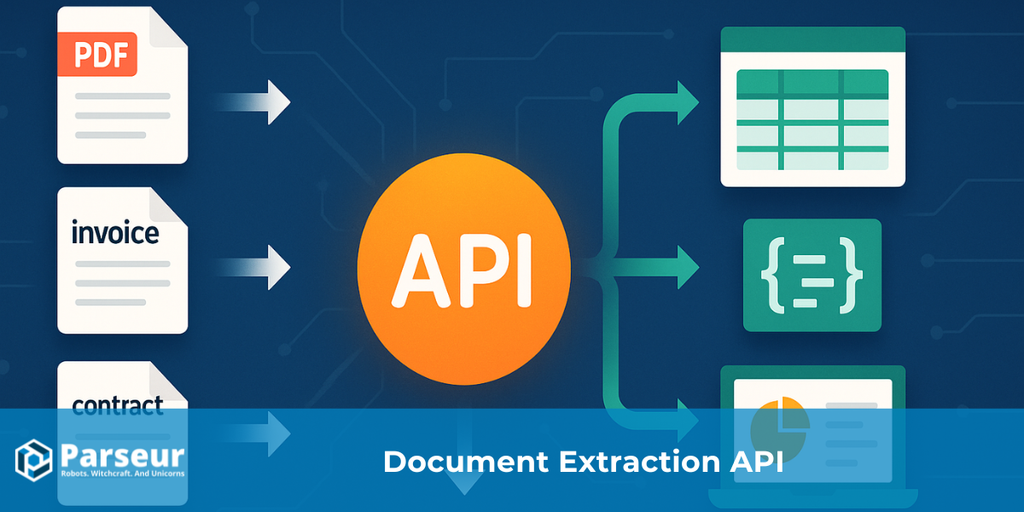

PDF, 이미지, 이메일 등에서 데이터를 추출하는 API는 보통 정보를 JSON이나 CSV와 같은 정형 데이터로 반환합니다. 이런 구조적 변환 덕분에 활용은 쉬워지지만, 실제로는 값 누락, 헤더 불일치, 타입 혼합, 중복, 날짜 오류 등 수많은 결함이 남아 있습니다. 이 오류를 정제하지 않으면 추후 보고/분석/재무 판단에 치명적 영향을 미칩니다.

이번 가이드는, 어수선한 추출 결과물을 신뢰성 높은 데이터셋으로 만드는 실전 플레이북을 제공합니다: 검증, 표준화, 보강, 테스트, 기록. 이메일, PDF 첨부파일 등 자동 추출에 Parseur 같은 도구를 쓰면, 데이터 캡처는 간소화하고 정제 및 품질에 집중하실 수 있습니다.

데이터 추출 API가 처음부터 끝까지 어떻게 작동하는지 더 자세히 알고 싶으시다면, 문서용 데이터 추출 API란? 완전 안내서를 꼭 참고해보세요.

데이터 정제 기법의 종류

데이터 추출 API를 이용해 데이터를 얻으면, 원본에는 프로그램 오류, 결측, 서식 에러, 중복이 반복적으로 발견됩니다. API가 PDF, 이미지, 이메일 등 비정형 파일을 정형 포맷(JSON, CSV)으로 바꿔도, 여전히 꼼꼼히 정제하지 않으면 신뢰도가 낮습니다.

Harvard Business Review에 따르면, 기업 데이터의 3%만이 기본 품질 기준을 충족하며, 신규 데이터의 47%에 최소 1개 이상의 치명적 오류가 있었습니다. 이런 문제는 실제로 큰 비용을 유발하는데, Gartner에 따르면 데이터 품질 문제로 연간 평균 1,500만 달러의 손실이 발생합니다.

믿을 수 있는 데이터 정제를 위해 반드시 필요한 대표 기법은 다음과 같습니다:

검증 및 오류 점검

날짜, 숫자, 이메일 등 데이터가 기대한 형식과 일치하는지 확인합니다. 분석이나 보고서 오류를 예방하고, API 추출 결과의 신뢰도를 높일 수 있습니다.

표준화

전화번호, 주소, 날짜 등은 일관적 포맷으로 통일하여 데이터셋을 쉽게 통합하고 활용할 수 있도록 만듭니다.

결측값 처리

데이터셋의 목적에 맞게 결측값을 보완, 보간, 혹은 불완전한 레코드를 삭제하는 방식 중 하나로 처리합니다.

중복 제거

API 반복 호출, 소스 중첩 등으로 생긴 중복 행을 제거하면 더욱 정확하고 신뢰도 높은 데이터세트를 구축할 수 있습니다.

데이터 보강

추출된 데이터의 활용도를 높이려면, 지리 정보나 분류 같은 맥락 정보를 추가해 풍부하게 만듭니다.

형식 및 타입 교정

데이터셋 전체의 일관성을 위해 잘못된 형식, 문자열↔숫자 변환, 오타 수정, 통화 표준화 등을 바로잡습니다.

로그 및 감사

API 추출의 정제 모든 작업을 기록해 품질을 모니터링하고 오랜 기간 데이터 무결성을 보장합니다.

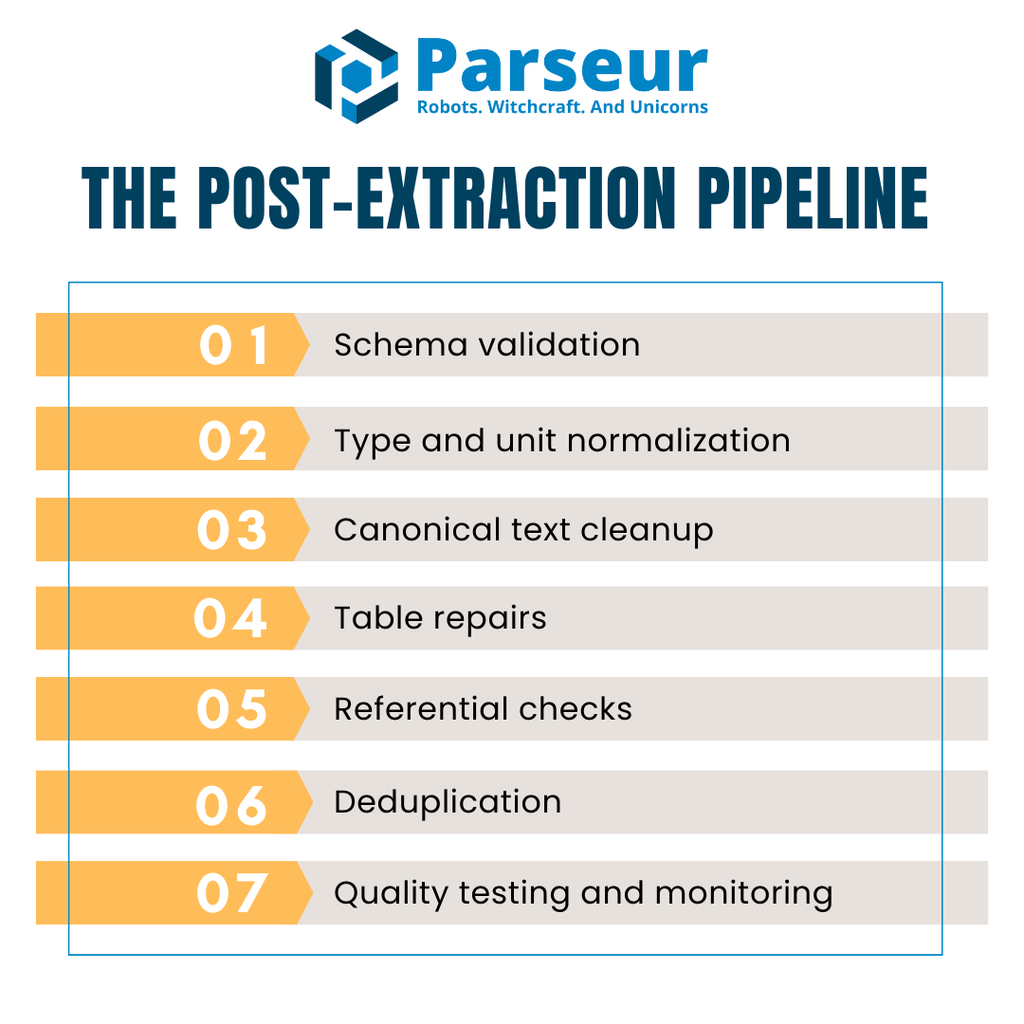

추출 후 파이프라인 개요

API에서 데이터를 추출해도, 분석이나 리포트에 바로 쓸 수 있는 경우는 드뭅니다. 원본에는 필드 누락, 타입 오류, 테이블 불일치, 중복 등 오류가 흔해, 매번 반복 가능한 구조화 정제 파이프라인이 필수입니다.

실무 파이프라인은 보통 아래 5~7개 기본 단계로 이루어집니다:

- 스키마 검증 – JSON이나 CSV가 예상 구조와 일치하는지 제일 먼저 확인

- 타입 및 단위 정규화 – 값의 타입을 바로잡고, 결측을 처리하며, 단위 및 포맷을 일관화

- 텍스트 정제 – 문자열을 표준화, 케이싱 통일, 유니코드 불일치 처리

- 테이블(표) 수정 – 헤더 정렬, 라인아이템 등 표 구조 정비 및 합계 대조

- 참조성 체크 – 공급업체, 통화, 세율 등 외부 레퍼런스의 일치성 검증

- 중복 제거 – 불필요한 중복은 삭제하지만, 실제 반복 데이터는 보존

- 품질 테스트 및 모니터링 – 자동화된 검사로 오류를 조기에 발견·방지

성능 향상을 위해 많은 팀이 정제 단계에서 Apache Arrow나 Parquet와 같은 컬럼형 포맷을 활용합니다. 대형 송장·트랜잭션 데이터에도 빠르고, 메모리 사용량이 줄어 병목을 완화할 수 있습니다.

즉, API → 검증 → 정제 → QA → 웨어하우스의 플로우로 프로세스를 정착시키면, 품질 일관성 유지 및 비용 절감을 동시에 실현할 수 있습니다.

1단계: 스키마 검증 (“쓰레기 데이터 유입 차단”)

API 추출 후 첫 번째 정제 단계는 스키마(구조) 검증입니다. 들어온 데이터가 기계가 읽을 수 있고 예상한 구조와 맞는지 반드시 확인해야 합니다. 이 단계를 건너뛰면 잘못된 데이터가 유입되어 파이프라인 후반에서 치명적인 장애를 일으킬 수 있습니다.

이 작업에 가장 널리 쓰이는 표준은 JSON Schema (Draft 2020-12)입니다. 라이브러리 생태계가 풍부하고, 도구에 종속되지 않으며, 휴대가 자유롭습니다. 원하는 데이터 구조(필드 타입, 필수/선택 속성, 포맷 규칙 등)를 정의할 수 있습니다. 예를 들어 invoiceDate는 ISO 8601을 따라야 하거나, total은 0 이상이어야 하는 식입니다.

파이썬 환경에서는 Pydantic v2가 런타임에서 구조와 타입을 즉시 검증하고, JSON Schema도 자동 생성해줍니다. 송장이나 라인아이템 등의 모델을 미리 지정해두면, 벤더 이름이 문자열임을 강제하고, 송장번호가 정규식에 맞는지 체크하며, 통화 역시 USD/EUR/GBP 등 정의해둔 목록과 매칭시킬 수 있습니다.

타입 검사에만 그치면 안 됩니다. enum 등 허용 값, 세금번호 같은 포맷의 정규식, 합계·수량의 범위 제한 등 다양한 제약조건을 추가하세요. 이런 가드레일로 미묘한 오류까지 차단할 수 있습니다.

마지막으로, 유효성 미달 데이터 처리 방침(즉시 거부 혹은 데드레터 큐 보관 등)도 선제적으로 설계해야 신뢰할 수 있는 데이터만 다음 단계로 전달할 수 있습니다.

2단계: 타입, 결측, 단위 교정

스키마 검증을 패스했다면, 타입 수정·결측 처리·단위 정규화가 우선순위입니다. 데이터 파싱 API가 JSON, CSV로 깔끔하게 내보내도, 수치값이 문자열이거나, 날짜 포맷 혼란, 행마다 null이 뒤섞인 경우가 아주 많습니다. 이런 상태를 방치하면 분석과 보고에서 신뢰할 수 없습니다.

**Parseur API**를 쓰면, 송장·영수증·이메일에서 데이터 추출 후 거의 바로 깨끗한 JSON으로 뽑아낼 수 있고, 실시간 Webhook 연동으로 ERP/CRM/DB 등에 자동 전달까지 가능합니다. 이 덕분에 사전 오류를 대거 차단하고 정제 속도도 높일 수 있습니다.

첫 단계로, 필드 값을 올바른 타입으로 강제 변환하세요. 예를 들어 quantity·unitPrice는 숫자 타입, invoiceDate/dueDate는 ISO 날짜, paid·approved는 true/false(Boolean)로 변환해야 합니다.

이어 결측값 처리를 위한 규칙을 선택하세요. 대표 방법은:

- 삭제(Drop): 비중요 필드라면 미완성 행 전체 삭제

- 대체(Fill): 기본값, 평균, 플레이스홀더 등으로 메움

- 플래그(Flag): 결측이 나타난 필드는 따로 표시해 검토

각 필드별 적용 규칙을 반드시 문서화해 전체 파이프라인에서 일관성을 유지해야 합니다.

파이썬 Pandas에서는 to_numeric(errors="coerce"), to_datetime(), fillna(), dropna() 등으로 타입·결측 처리 작업을 빠르고 유연하게 할 수 있습니다. 이렇게 기반이 깔끔해야 이후 단계(텍스트 정제·테이블 수정·참조성 체크)가 무리 없이 진행됩니다.

타입, 결측, 단위 교정을 초기에 끝내야 이후 텍스트 정제, 테이블 보정, 참조성 체크 작업이 안전하게 이루어집니다.

3단계: 텍스트 일관화 (이름·케이스·유니코드 등)

숫자와 날짜 필드까지 정비했다면, 이제 텍스트 데이터 정제가 시작됩니다. 업종 현장에선 업체명이나 값의 케이싱, 띄어쓰기, 인코딩 혼란 때문에 정확한 그룹핑·매칭이 방해될 수 있습니다.

먼저 공백·구두점 정리로 시작하세요. 불필요한 앞뒤 공백, 이중/이상 공백, 특수문자 등을 지웁니다. 이어 케이싱 규칙 적용, 예를 들어 업체명은 타이틀 케이스, 송장 처리 상태는 모두 대문자 등으로 맞추면 검색·분류가 훨씬 쉽습니다.

유니코드 정규화도 매우 중요합니다. 같은 문자라도 encoding 차이로 “같아 보이지만 다른” 문자열이 생길 수 있습니다. 대체로 NFKC로 정규화하면 악센트·기호·구두점까지 일관화할 수 있습니다. 특히 다국적 데이터에선 “Café”와 “Cafe”를 통합 관리해야 하므로, 악센트 제거도 고려해야 합니다.

마지막으로, 업체명 등 주요 필드는 **표준화 리스트(카노니컬리스트)**를 구축해 “Inc.”↔“Incorporated” 등 동등한 값을 치환하거나, 머신러닝 기반 엔터티 정규화로 한 단계 더 나아갈 수 있습니다.

텍스트 일관화를 착실히 수행하면, 데이터 출처별 표기차로 인한 중복·분할·비정상 리포트가 크게 줄어듭니다.

4단계: 테이블(라인아이템) 보정

API 추출 후 라인아이템 테이블은 종종 가장 많은 보정이 필요합니다. 헤더가 여러 행에 나뉘거나, PDF에서 셀이 회전되어 추출되거나, 값이 잘못 합쳐져 분석이 어렵게 나오는 경우가 많습니다. 헤더를 반드시 단일화하여 각 열이 미리 정의한 스키마와 1:1 매칭되는지 확인이 선행되어야 합니다.

구조 정리가 끝나면, 단위 및 통화도 표준화합니다. 예를 들어 kg와 lbs 통일, 여러 송장 간 통화 변환 등입니다. 각 행의 amount = quantity × unitPrice로 재계산 후 송장 총액과 오차가 없는지도 확인해야 합니다. 오차가 발생하면 즉시 플래그하여 누락이나 중복 행이 감지되도록 해야 합니다.

CSV 등 테이블 내보내기는 별도의 복잡성이 있습니다. 숨은 구분자, 잘못된 인용부호, 인코딩 불일치로 컬럼 구조가 깨질 수 있습니다. DuckDB 등 유연한 툴을 활용해 구분자·인용부호·인코딩을 명시 지정하면, 복잡한 CSV도 안전하게 불러오고 타입 캐스팅으로 정리할 수 있습니다.

이 과정을 거치면 혼란스러운 표도 신뢰성 있는 행 단위로 변환돼, 분석·재무팀이 즉시 사용할 수 있습니다. 핵심은 단순히 합계 맞추기뿐 아니라, 어떤 문제도 조용히 리포트에 녹아들지 않도록 하는 데 있습니다.

5단계: 참조 및 비즈니스 규칙 적용

개별 행이 아무리 올바르게 보여도, 표 전체나 테이블 간 관계를 비교하면 문제는 반드시 드러납니다. 참조 체크는 값의 일관성과 비즈니스 룰 준수 여부를, 데이터가 웨어하우스에 들어가기 전에 보장합니다.

가령 invoices 테이블의 vendorId는 반드시 기본 vendors 테이블에 존재해야 하며, 통화코드는 회사가 허용한 것만 써야 하고, 세율은 실제 관할 지역과 일치해야 합니다. 미리 이런 문제를 포착하면 조인 오류·잘못된 리포트·준법 위반을 막을 수 있습니다.

현대 데이터팀은 이런 규칙을 변환 계층에 직접 적용합니다. DBT 테스트(unique, not_null, accepted_values, relationships 등)를 선언해, 예를 들어:

- unique(중복불가—예: 송장번호)

- not_null(필수필드—예: 업체ID)

- accepted_values(허용값—예: 통화코드)

- relationships(외래키—참조무결성)

등을 코드로 자동 검증합니다.

이런 참조 무결성 자동화가 있으면 오류가 즉시 드러나고, 반복적인 수기 점검·늦은 감사에서 문제가 뒤늦게 밝혀지는 상황을 방지할 수 있습니다.

6단계: 중복 제거 및 레코드 결합

중복 레코드는 데이터 신뢰성을 조용히 갉아먹습니다. 합계 부풀리기, 이중 지급, 감사 혼란 등의 문제도 종종 중복에서 비롯됩니다. 따라서 API 추출 후에는 진짜 중복만 안전하게 정제하는 전략이 필요합니다.

처음에는 결정적 키를 정의해 완전 일치 중복을 제거합니다. 예를 들어 supplierName, invoiceNumber, invoiceDate, amount, currency 조합이 모두 같다면 거의 확실히 중복입니다.

그러나 실제 현장에선 유사 중복도 흔합니다. 예를 들어, 7일 이내 유사 금액 송장이 같은 업체에서 반복되는 경우(금액 차 1% 이내 등)는 부정확한 이중 입력일 수 있습니다. 이럴 땐 플래그로 검토해야 하며, 실수로 정상 자료를 잃지 않도록 조심해야 합니다.

중요한 점은 문자열(구문) 매칭만이 아니라 의미 기반 매칭(예: “Acme Corp.”와 “ACME Corporation” 실질적으로 동일)도 고려해야 한다는 점입니다. OpenRefine와 같은 클러스터링 도구로 비슷한 필드를 그룹핑하여 수동 검토 작업을 크게 줄일 수 있습니다.

결정적·퍼지·의미기반 중복 제거가 조화되면, 정확성과 안전성을 모두 갖춘 중복 삭제가 실현됩니다.

7단계: 데이터 품질 자동화 검사

데이터 품질 관리는 한 번만 하고 끝낼 수 없습니다. 아무리 철저히 정제해도, 새 추출 데이터에는 언제든 오류가 침투할 수 있습니다. 자동화된 품질 검사가 있어야, 리포트·판단에 영향을 주기 전 오류를 꾸준히 차단합니다.

대표적 솔루션이 **Great Expectations (GX)**입니다. GX는 “Expectation”이라는 규칙을 선언하여, 송장번호 정규식 매칭, 수량·단가의 범위 확인, 행 개수 체크 등 다양한 테스트를 자동화합니다. CI/CD 파이프라인과 연동하면 추출 품질 저하 시 바로 알 수 있습니다.

파이썬 기반 파이프라인엔 Pandera도 좋습니다. 데이터프레임 상에서 타입·범위·결측 유무를 코드로 선언해 즉시 미달 행은 차단하거나 이상 경고를 띄웁니다.

자동화는 결과가 가시적일 때 효과가 있습니다. 품질 검사 결과는 대시보드나 알림 시스템으로 전파해, 전체 행 중 오류 비율, 통과/실패 건수, 에러 상세 등을 공유하세요. 그래야 이슈를 빠르게 파악·수정할 수 있습니다.

이렇게 데이터 품질을 가시적이고 지속적으로 관리하면, 모든 정제 데이터셋의 생산준비·정확성·일관성이 유지됩니다.

성능·저장 팁 (정제 단계가 병목이 되지 않으려면)

추출 후 데이터 정제는 꼭 필요하지만, 파이프라인 속도 저하로 이어져선 안 됩니다. 대량 송장·영수증·트랜잭션 작업에서 비효율적 정제는 지연·비용 증가·운영팀 혼란을 야기합니다. 핵심은 "품질은 타협 없이, 속도 저하 없이"라는 점입니다.

MDPI 연구에 따르면 데이터 정제는 데이터 실무자의 최대 80% 시간을 소모한다고 밝혔으며, 데이터 처리 효율에 절대적 영향을 끼칩니다. 이 점은 파이프라인 최적화의 중요성을 다시 강조해줍니다.

현장 성능을 유지하는 실질적 전략은 다음과 같습니다:

- 컬럼형 포맷 활용 — Apache Arrow, Parquet 등은 벡터 연산 가능·메모리 사용 최소화로 대용량 정제에 유리합니다. 분석 엔진·파이썬 라이브러리도 쉽게 연계됩니다.

- 배치 및 병렬 처리 — 행 단위 처리 대신, 배치 작업/비동기 태스크로 여러 파일을 동시 처리해 대기시간을 최소화하세요.

- 창고 기반 처리 도구 병행 — 대형 CSV, 복잡한 조인은 DuckDB 등으로 웨어하우스나 서버 내에서 처리하면, 로컬 파이프라인 부담을 줄이고 변환 속도를 높일 수 있습니다.

- 중간 결과 캐시 활용 — 반복 검사, 정규화 필요시 캐시를 활용하면 같은 데이터의 재처리를 줄일 수 있습니다.

- 시스템 자원 모니터링 — CPU·메모리·I/O 사용량을 수시로 추적해, 속도 저하 원인을 조기에 막으세요.

정제 파이프라인도 정확성과 확장성의 균형이 필요합니다. 컬럼 포맷 도입, 배치화, 현명한 자원 분배로 실시간 분석·리포트 환경을 실현할 수 있습니다.

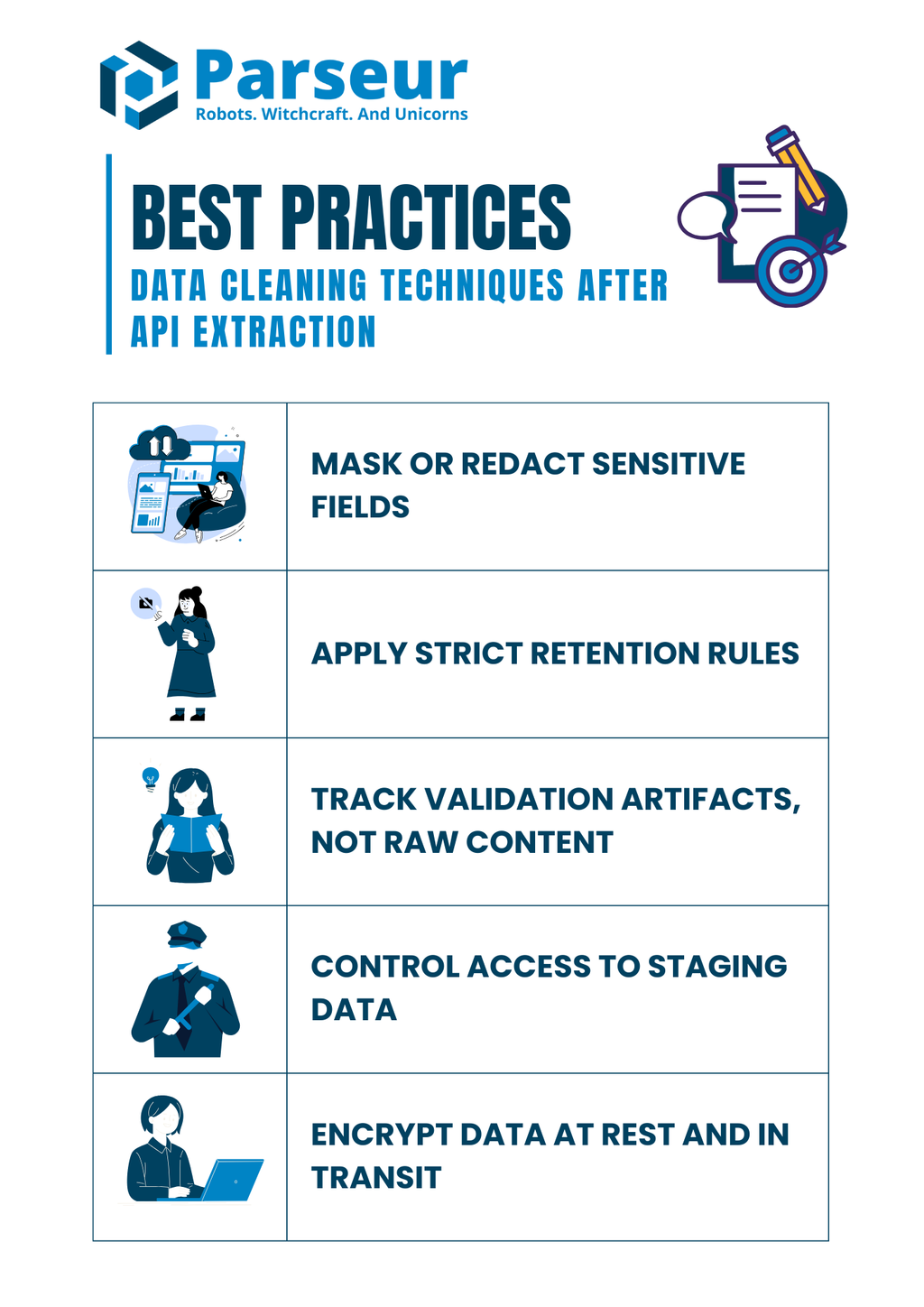

보안·준법(Compliance) 주의사항

데이터 정제는 단순 오류 검출을 넘어서, 보안·준법 측면에서도 매우 중요합니다. 추출된 문서에는 핀테크·세금·직원 정보 등 민감 데이터가 흔히 포함되며, 이 필드가 부적절하게 처리되면 웨어하우스 유입 전 이미 리스크가 생길 수 있습니다.

Mitratech 연구에 따르면, 61%의 조직이 취약한 데이터 거버넌스에서 비롯된 침해·비효율·준법 문제를 겪고 있습니다. 즉, 데이터 품질과 함께 규정 준수도 적극 강화해야 함을 보여줍니다.

정제 단계에서 컴플라이언스를 지키는 가장 효과적인 실무 가이드:

- 민감 필드 마스킹/삭제 — SSN, 카드번호, 계좌번호 등은 로그에 그대로 저장하지 말고, 반드시 마스킹이나 해시화 후 기록

- 엄격한 보존 정책 — 추출 원본은 필요 이상 오래 저장하지 말고, 규정에 맞는 보존 기간만 관리

- 결과/아티팩트만 추적 — 결측·오류 필드/원인만 기록하고, 민감 원본 파일은 별도 보관하지 않기

- 스테이징 데이터 접근 통제 — 역할별 권한 관리로, 임시 데이터도 승인된 인원만 접근 가능하게 제한

- 저장·전송 구간 암호화 — 임시·영구 데이터베이스, 파일, 로그 모두 암호화 처리로 노출 위험 최소화

즉, 기술적 정제 전 과정에서 컴플라이언스 컨트롤이 병행되어야만, 각종 벌금이나 신뢰하락 리스크 없이 고객/조직의 보안 신뢰도를 지킬 수 있습니다.

실전 예시 (정제 파이프라인의 실제 적용)

실제 프로세스 예시는 전체 단계—스키마 검증, 정규화, 합계 대조, 품질 검사—를 하나의 파이프라인으로 묶어 설명합니다. Parseur API로 PDF나 이메일에서 송장 데이터를 추출했다 가정해보겠습니다. Parseur는 비정형 문서를 곧바로 정형 JSON으로 변환해 정제 시작점이 되어줍니다.

예시 추출 JSON(입력):

{

"invoiceNumber": "INV-001",

"invoiceDate": "2025/08/15",

"vendorName": "Acme, Inc.",

"lineItems": [

{ "description": "Widget A", "quantity": "10", "unitPrice": "5.00" },

{ "description": "Widget B", "quantity": "3", "unitPrice": "12.50" }

],

"total": "87.50"

}

1단계: Pydantic으로 스키마 검증

from pydantic import BaseModel, Field

from datetime import date

from typing import List

import pandas as pd

# LineItem 모델 정의

class LineItem(BaseModel):

description: str

quantity: int

unitPrice: float

# Invoice 모델 정의

class Invoice(BaseModel):

invoiceNumber: str

invoiceDate: date

vendorName: str

lineItems: List[LineItem]

total: float

# 예시 원본 JSON

raw_json = """

{

"invoiceNumber": "INV-001",

"invoiceDate": "2025-08-15",

"vendorName": "Acme, Inc.",

"lineItems": [

{ "description": "Widget A", "quantity": 10, "unitPrice": 5.00 },

{ "description": "Widget B", "quantity": 3, "unitPrice": 12.50 }

],

"total": 87.50

}

"""

# JSON을 Invoice 모델로 파싱

invoice = Invoice.model_validate_json(raw_json)

# 라인아이템을 Pandas DataFrame으로 정규화

df = pd.DataFrame([item.model_dump() for item in invoice.lineItems])

df["amount"] = df["quantity"] * df["unitPrice"]

# 합계 검증

if round(df["amount"].sum(), 2) != invoice.total:

print("불일치: 라인아이템 합이 송장 총액과 다릅니다")

else:

print("합계 일치 ✅")

print(df)

3단계: Great Expectations로 품질 테스트

import great_expectations as gx

# Great Expectations 컨텍스트 초기화

context = gx.get_context()

# Pandas DataFrame을 배치로 로드

batch = context.sources.pandas_default.read_dataframe(df)

# Validator 객체 받아 expectations 실행

validator = batch.get_validator()

# 검증 규칙 선언

validator.expect_column_values_to_be_between("quantity", min_value=1, max_value=1000)

validator.expect_column_values_to_be_between("unitPrice", min_value=0, max_value=10000)

validator.expect_column_sum_to_be_between("amount", min_value=0, max_value=100000)

# 검증 결과 캡처 및 출력

results = validator.validate()

print(results)

정제 결과 (예상):

- 송장 데이터가 요구 스키마 상에 정확히 검증됨

- 날짜와 숫자가 타입에 맞게 변환됨

- 합계가 오차 허용 범위 내에서 일치함을 검증

- 컬럼별 품질 테스트로 값의 범위와 구조까지 자동 확인

이런 식의 엔드-투-엔드 프로세스를 거치면, API의 지저분한 원본도 초기에 신뢰성 검증과 결정적 정제를 거친 뒤, 바로 생산 시스템에 넣을 수 있는 깔끔하고 안전한 데이터로 변환할 수 있습니다.

데이터 정제는 신뢰성 있는 데이터 파이프라인의 한 부분일 뿐이며, 첫 단계는 문서에서 정확하고 정형적인 데이터를 추출하는 것입니다. 이때 Parseur의 직관적 플랫폼과 강력한 Parseur API를 활용하면, PDF, 이메일, 스프레드시트, 첨부파일 등에서 데이터를 자동 추출해 수작업 부담을 획기적으로 줄일 수 있습니다. 즉시 수집된 데이터에 본 가이드의 정제 기법을 적용하면, 일관된 정확성의 분석용 데이터셋을 얻을 수 있습니다.

앞으로는, Gartner가 예측한 대로 2026년까지 신규 클라우드 도입의 70%가 수동형 포인트 솔루션이 아니라 유기적으로 연결된 클라우드 데이터 생태계로 전환될 전망입니다. 이는 클린·정형 데이터와 API 중심 추출 자동화의 중요성이 더욱 커짐을 시사합니다.

팀이 전체 흐름을 더 잘 이해하고 싶으시다면, API가 문서 처리 방식을 어떻게 혁신하고 적합한 도구를 고르며 워크플로를 최적화하는지에 대한 종합 가이드를 참고하세요. 문서용 데이터 추출 API 완전 가이드에서, 복잡한 원본부터 정확하고 실전적인 데이터로 전환하는 최적의 방법을 확인하실 수 있습니다.

자주 묻는 질문

마무리 전에, API 추출 후 데이터 정제에 대해 자주 묻는 질문을 소개합니다. 이 간단한 답변들은 팀에서 흔히 겪는 실수와 실무적인 고민을 다룹니다.

-

합계가 누락된 행은 삭제해야 하나요?

-

무작정 삭제하기보다는 별도로 검토·조사하는 것이 좋습니다. 합계는 재무상의 핵심 필드이므로, 조용히 삭제하면 보고서가 왜곡될 수 있습니다. 검토 버킷 등에 보관하면 투명성 유지와 적절한 해결이 가능합니다.

-

정제 전에 올바른 JSON임을 어떻게 보장하나요?

-

JSON Schema나 Pydantic을 활용하여 데이터가 기계가 읽을 수 있고 예상 필드와 일치하는지 확인하세요. 불량 JSON을 조기에 잡으면 다운스트림 수정에 드는 시간을 아낄 수 있습니다.

-

데이터 웨어하우스 없이 품질 테스트가 가능한가요?

-

네. Great Expectations나 Pandera 같은 도구를 활용해 파이썬 파이프라인이나 CI/CD 워크플로 내에서 직접 규칙을 검사할 수 있습니다. 데이터가 웨어하우스에 적재되기 전에도 품질 관리가 가능합니다.

-

테이블 합산이 송장 총액과 다르면?

-

라인아이템의 합계가 송장 총액과 오차 범위 내에서 일치하는지 조정 규칙을 만드세요. 불일치는 덮어쓰지 말고 반드시 검토 대상에 포함시켜야 합니다.

-

상위에서 테스트했다면 DBT 테스트도 꼭 필요한가요?

-

네. DBT 테스트는 모델 계층에서 제약조건을 코드화하여 추가적인 안전망을 제공합니다. 상위 테스트가 있어도, 이중 방어 구조가 있어야 불량 데이터의 생산 분석 유입을 막을 수 있습니다.

-

CSV 내보내기 시 인코딩 오류는 어떻게 다루나요?

-

파싱 시 구분자, 인코딩, 인용문자를 명확히 지정하세요. DuckDB 등 도구를 사용하면 복잡한 파일도 진단·정규화하여, 여러 소스에서 가져온 데이터의 일관성을 확보할 수 있습니다.

마지막 업데이트