Najważniejsze wnioski

- Do 2030 roku HITL stanie się kluczowym elementem projektowania zaufanej i wyjaśnialnej AI.

- Regulacje wymuszą nadzór człowieka wszędzie tam, gdzie AI decyduje o sprawach wrażliwych.

- Synergia człowiek–AI będzie napędem etycznej, skalowalnej automatyzacji.

Hybrydowa przyszłość AI i ludzi

Patrząc w kierunku 2030 roku, staje się jasne: najbardziej zaawansowane systemy AI nie będą zwyciężać same szybkością czy autonomią, lecz poziomem zaufania. To zaufanie rodzi się z harmonii – połączenia mocy automatyzacji z doprecyzowaną przez człowieka ekspertyzą.

Wstępne wdrożenia AI pokazały, że choć autonomiczne systemy bywają efektywne, towarzyszą im ryzyka: uprzedzenia, nieprzejrzystość, trudność w przewidywaniu ich decyzji. To właśnie te ryzyka wywołały renesans zainteresowania systemami HITL oraz AI zorientowaną na człowieka – nie jako plan awaryjny, lecz jako przemyślaną strategię przyszłości.

Według szacunków, już w 2026 roku ponad 90% treści online będzie generowane przez AI zamiast przez ludzi. Zmiana ta jeszcze wyraźniej uwidacznia kwestie zaufania i potrzeby kontroli nad automatycznymi systemami, jak podkreśla Oodaloop.

Dla podstaw, zobacz nasz przewodnik Human-in-the-Loop AI: Definicja i korzyści — praktyczny wstęp do obecnych zastosowań i wartości biznesowej workflow przyszłości-human-in-the-loop-ai.

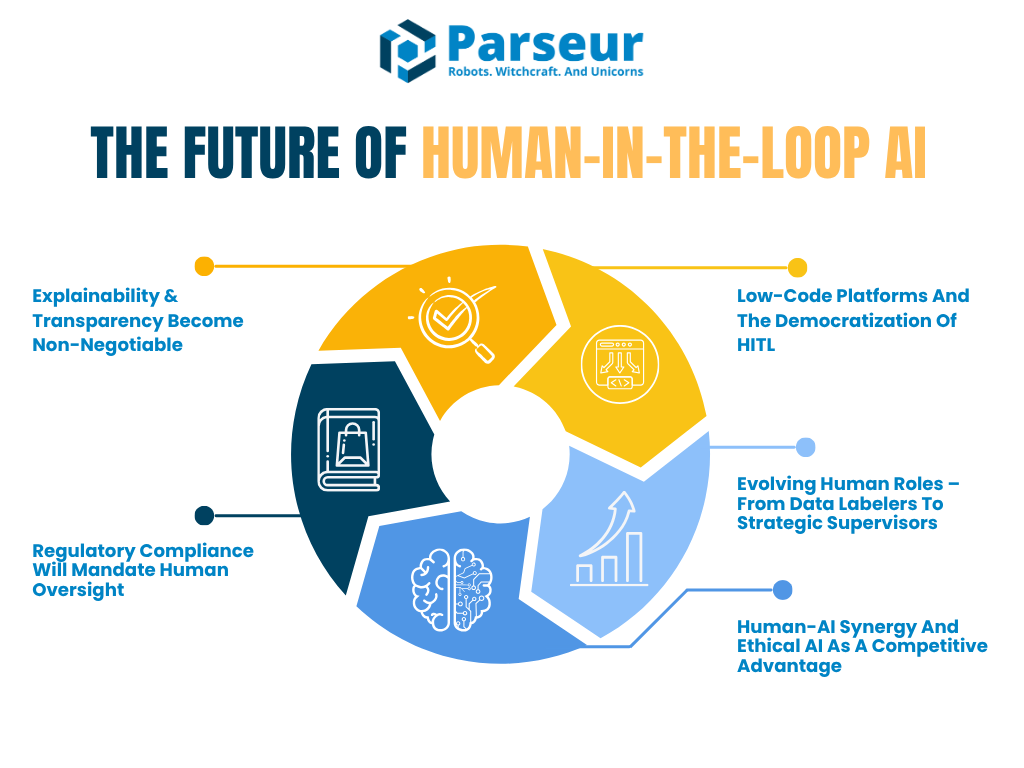

W tym artykule omawiamy ewolucję HITL do 2030 roku oraz 5 kluczowych trendów kształtujących przyszłość współpracy ludzi i AI:

- Wzrost wymagań wobec wyjaśnialnej i audytowalnej AI

- Postępujące obostrzenia regulacyjne wymuszające nadzór człowieka

- Rozwój platform low-code ułatwiających wdrożenie HITL

- Zmiana ról ludzkich – od prostych zadań do strategicznego nadzoru

- Jak synergia ludzi i AI staje się przewagą biznesową

Według Venture Beat wizjonerzy tacy jak Reid Hoffman przewidują przyszłość, gdzie AI superagency: „Człowiek, który nie korzysta z AI, zostanie zastąpiony przez człowieka, który to robi”. AI staje się więc mnożnikiem produktywności, a nie zagrożeniem.

Potwierdzają to dane z Barometru AI 2026 PwC: po popularyzacji generatywnych AI w 2022 roku wzrost produktywności w branżach ‘AI-exposed’ niemal się poczwórzył z 7% (2018-2022) do 27% (2018-2024). Pokazuje to, jak AI wzmacnia ludzką efektywność w sektorach takich jak finanse czy IT.

Dziś firmy nie muszą już wybierać między automatyzacją a pewnością działania. Przyszłość należy do hybrydowych architektur AI z wbudowaną oceną człowieka w newralgicznych miejscach – zarówno w modelach in-the-loop, jak i on-the-loop.

Trend 1: Wyjaśnialność i przejrzystość jako standard

Kiedy AI podejmuje decyzje wpływające na rzeczywistość, pytanie nie brzmi już „czy AI dobrze wykonuje zadanie?”, tylko „czy człowiek może zrozumieć i wyjaśnić te decyzje?”. To rosnąca rola wyjaśnialnej AI (XAI) i przejrzystości.

W nadchodzących latach wyjaśnialność stanie się absolutnym wymogiem, szczególnie w ryzykownych sektorach (finanse, zdrowie, ubezpieczenia, prawo). Workflow human-in-the-loop zapewniają nie tylko czuwanie – umożliwiają biznesom spełnienie wymogów regulacyjnych i etycznych, oddając ludziom rolę w interpretacji i tłumaczeniu wyników AI.

Według Gartner, do 2026 roku ponad 80% firm wdroży API generatywnej AI lub aplikacje generatywne. To podkreśla, jak paląca staje się potrzeba przejrzystości i udziału człowieka w procesach AI w krytycznych branżach.

Przykładowo, EU AI Act już wymaga, by AI wysokiego ryzyka posiadały nadzór człowieka i zdolność wyjaśniania decyzji. Podobnie NIST AI Risk Management Framework ostrzega: brak ról HITL i niska przejrzystość to największe wyzwania. Wkrótce takie standardy będą formalnie obejmować dokumentowanie ludzkiej kontroli.

Co dalej: human-in-the-loop z interfejsem wyjaśnień

Do 2030 roku systemy AI zyskają prawdopodobnie wbudowane interfejsy wyjaśnień. Będą pozwalały recenzować decyzje AI, wyświetlając np. 3 główne powody podjęcia decyzji przez algorytm – recenzent dostaje przejrzysty kontekst do oceny zgodności z polityką firmy i regulacjami.

HITL ewoluuje z ręcznej weryfikacji każdej operacji w kierunku strategicznego potwierdzania kluczowych etapów procesu. Nie chodzi już o zatwierdzanie linii po linii, lecz o potwierdzenie, że logika AI pokrywa się z wartościami firmy i standardami uczciwości.

Branże już w awangardzie

Zdrowie i finanse są liderami zmian. Wyjaśnialność tutaj to nie preferencja, a wymóg. Zgodnie z raportem Deloitte Tech Trends 2026: „Im bardziej złożony system, tym bardziej kluczowa ludzka rola”. Im bardziej zaawansowana automatyzacja, tym istotniejszy nadzór człowieka.

Coraz popularniejsze stają się także modele „human-on-the-loop”, gdzie człowiek nie interweniuje na bieżąco, lecz stale monitoruje AI i może przejąć kontrolę, gdy zajdzie potrzeba (jak pilot ma nadzór nad autopilotem).

Znaczenie trendu

Wyjaśnialność podkreśla uniwersalną prawdę: bez zaufania nie ma skalowalnej AI. To właśnie przejrzystość buduje zaufanie. Firmy mogą być zobowiązane do prowadzenia „logów wyjaśnień”, raportów i regularnych audytów, w których przypisana osoba sprawdza motywacje i decyzje AI.

Nowe role nie będą już tylko reaktywne – staną się aktywną siłą kształtującą rozwój i etykę AI.

Trend 2: Regulacje wymuszą ludzki nadzór

Wraz z ekspansją AI rosną również prawne oraz etyczne zobowiązania. Regulatorzy wymuszają teraz odpowiedzialność i stały nadzór człowieka nad systemami automatycznymi. Od 2026 do 2030 roku czeka nas fala przepisów formalnie wymagających procesów Human-in-the-Loop tam, gdzie decyzje AI mają istotny wpływ na życie ludzi.

Instytucje takie jak Unia Europejska, Stany Zjednoczone i NIST są zgodne: AI nie może być czarną skrzynką. Osoby dotknięte decyzją AI muszą mieć szansę ją zrozumieć, zakwestionować i domagać się przeglądu przez człowieka.

W samych USA w 2024 roku pojawiło się ponad 700 ustaw dot. AI, a w 2026 – już ponad 40 nowych inicjatyw, donosi Naaia. Oznacza to coraz większy nacisk na przejrzystość oraz nadzór człowieka.

Zgodnie z art. 22 RODO, osoby mogą wymagać interwencji człowieka przy decyzjach podejmowanych automatycznie. Nadchodzący EU AI Act jeszcze mocniej wymusza istotną rolę człowieka przy nadzorze nad systemami wysokiego ryzyka. To już nie trend – to rodzący się globalny standard.

Co dalej: systemy ‚compliance HITL’

Do 2030 roku wiele firm wdroży procesy ”compliance HITL”:

- Regularne przeglądy i audyty decyzji AI przez ludzi.

- Tworzenie zespołów nadzoru AI, działających jak centra dowodzenia w lotnictwie czy cyberbezpieczeństwie.

- Odpowiedzialne punkty decyzyjne z udziałem człowieka – zwłaszcza tam, gdzie ryzyko jest szczególnie istotne.

Narzędzia i platformy coraz częściej umożliwiają takie audyty. Dashbordy pozwalają śledzić dokładność AI i częstotliwość manualnych nadpisań – będzie to kluczowa metryka zgodności.

Eksperci: hybrydowy nadzór AI staje się normą

Coraz więcej organizacji korzysta z hybrydowych podejść: automatyzacji wspartej bieżącym nadzorem specjalistycznych zespołów. Według Gartner, 67% rozwiniętych firm tworzy dedykowane zespoły AI oraz nowe role – AI Ethicist, Model Manager, Knowledge Engineer – by zapewnić odpowiedzialne wdrożenia AI.

Branże analityczne już dziś wdrażają te praktyki, a do 2030 roku stanowiska “AI Auditor”, „AI Risk Manager” czy „Human-in-the-Loop Supervisor” staną się powszechne.

Regulacyjne wyjaśnialność i audyt

Regulacje nie wymagają już tylko obecności ludzi – oczekują, że będą oni w stanie wyjaśnić proces decyzyjny AI. To silna korelacja z poprzednim trendem. Dokumentowanie i audyt staną się codziennością. NIST AI RMF zaleca, by użytkownicy mogli przejąć kontrolę nad AI i by regularnie monitorowano jej wyniki — za brak tego mogą grozić sankcje prawne albo utrata certyfikacji.

Pojawią się także certyfikaty AI z ludzkim nadzorem, potwierdzające odpowiedzialność i wiarygodność wdrożeń.

Trend 3: Platformy Low-Code demokratyzują HITL

Jeszcze niedawno budowa workflow HITL wymagała dużych inwestycji IT, integracji i biegłości AI. Dziś bariera ta znika. Już od 2026 roku platformy low-code i bezkodowe pozwolą tworzyć systemy HITL szerokiemu gronu użytkowników.

Możesz dodać kroki recenzji człowieka do procesu AI bez pisania kodu. Już teraz narzędzia typu UiPath, Microsoft Power Automate czy Amazon A2I oferują workflowy z drag&drop obejmujące recenzje czy zatwierdzenia manualne.

Co dalej: workflow AI prosto z biznesu

W perspektywie kilku lat workflow AI z opcjami HITL będą standardem. Do 2026 roku 70% liderów CX planuje wdrożyć Generatywną AI, korzystając z narzędzi HITL dla zapewnienia jakości, jak podaje AmplifAI.

To prawdziwa demokratyzacja — działy biznesowe, prawne czy finansowe będą mogły samodzielnie wdrażać nadzór człowieka i szybciej oraz sprawniej skalować AI.

Wkrótce również LLM mogą same rekomendować wdrożenie HITL w newralgicznych miejscach workflow, analizując pewność predykcji czy ryzyko. Dashboardy pozwalają monitorować proces, flagować anomalia i poprawiać działanie AI na podstawie feedbacku.

Human review na żądanie (crowd-powered)

Popularny staje się model recenzji na żądanie, prowadzony przez „tłum”. Usługi jak Amazon Mechanical Turk lub BPO mogą przeprowadzać masową weryfikację w pipelinie AI, pozwalając na skalowalny HITL bez rozbudowy własnych zespołów specjalistów.

Przykładowo: e-commerce poddaje recenzje komentarzy AI, ale zgłoszenia wątpliwe trafiają do kolejki dla zdalnych weryfikatorów HITL – szybko, tanio i wydajnie.

Ekspresowe wdrażanie HITL

Nowoczesne platformy low-code pozwalają na błyskawiczną implementację HITL, a zaawansowani użytkownicy mogą korzystać z elementów programistycznych. Bariery techniczne praktycznie zniknęły – wdrożenie HITL będzie tak łatwe jak kampania mailingowa lub budowa strony WWW.

Platformy takie jak Parseur umożliwiają własne szablony lub element kontroli manualnej, gdy nie chcesz polegać wyłącznie na AI. W miarę jak HITL staje się normą automatyzacji inteligentnej, rozwiązania typu Parseur odegrają kluczową rolę w masowym wdrażaniu workflowów przyszłości-human-in-the-loop-ai.

Trend 4: Zmiana ról ludzkich — od manualnych zadań do strategicznego nadzoru

Wczesne fazy wdrożeń AI skupiały uczestnictwo człowieka na żmudnym tagowaniu i weryfikacji outputów. Ale dziś coraz więcej tych zadań przejmują AI lub tzw. crowdsourcing. Nie oznacza to jednak, że ludzie są marginalizowani – ich rola przesuwa się w stronę strategiczną i ekspercką.

Według Statista 2026, w 2026 roku udział człowieka w zadaniach to 47%, maszyn 22%, a 30% wymagało współpracy obu. Do 2030 roku proporcje te będą się zmieniać na rzecz maszyn — ale strategiczny nadzór HITL pozostanie kluczowy.

Co dalej: HITL 2.0 i specjaliści ds. nadzoru AI

Nadchodzi era „Human-in-the-Loop 2.0”, w której człowiek jest nie tylko recenzentem, ale również trenerem, doradcą i menedżerem ryzyka AI.

Przykład: lekarz korzystający z AI do wsparcia diagnostycznego nie analizuje każdego przypadku, ale interweniuje, gdy system sygnalizuje niepewność lub anomalię – ta współpraca poprawia wyniki i uczy zarówno algorytm, jak i jego nadzorcę.

Według World Economic Forum do 2030 roku 60% pracodawców będzie szukało osób z umiejętnościami analitycznymi i przywódczymi, a zapotrzebowanie na prace manualne spadnie.

Coraz szerzej wdrażany będzie również model human-on-the-loop – człowiek stale monitoruje procesy AI i przejmuje sterowanie wyłącznie w sytuacjach odstępstw, działając podobnie jak kontrolerzy ruchu lotniczego.

AI wspierająca nadzorców

AI coraz częściej wspomaga sam proces nadzoru. Przykładowo, narzędzie może wysłać sygnał Compliance Officerowi: „Ta decyzja odbiega od norm – sprawdź”. Tak powstaje nowa, dynamiczna pętla współzarządzania przez AI i człowieka.

Nowe role na horyzoncie

Do 2030 roku powszechne będą stanowiska takie jak:

- AI Feedback Specialist

- Algorithm Ethics Officer

- Model Behavior Coach

- Human-in-the-Loop Supervisor

Ich odpowiedzialność to nie tylko jakość, ale i kierunek rozwoju AI.

Według raportu Deloitte Global Human Capital Trends 2026, 57% liderów widzi potrzebę uczenia ludzi, jak myśleć razem z AI — nie tylko jak ją obsługiwać. To przesuwa ich rolę z wykonawców do strategicznych partnerów.

Trend 5: Synergia człowiek–AI i etyka jako przewaga rynkowa

Przyszłość AI to nie pojedynek człowieka z maszyną, tylko współpraca prowadząca do lepszych, etycznych i precyzyjnych decyzji biznesowych. Do 2030 roku najbardziej konkurencyjne organizacje będą opanowywać równowagę automatyzacji z ludzkim osądem.

To tzw. inteligencja wspierana (augmented intelligence) – połączenie (AI: tempo, skala, analiza) + (człowiek: etyka, empatia, wiedza domenowa) = najlepsze decyzje.

55% firm powołało już board lub ciało ds. AI, podkreślając wagę nadzoru i etyki — Gartner.

Dlaczego wygra synergia

Do 2026 roku „human-in-the-loop” nie będzie już opcjonalnym zabezpieczeniem – zostanie niezbędną cechą zaufanej AI. Decyzje kredytowe, kadrowe, zdrowotne muszą być zatwierdzane przez ludzi, by zachować rzetelność i zaufanie.

Marki zaczną aktywnie komunikować HITL jako element przewagi rynkowej. Pojawią się oznaczenia „Human-Verified AI” lub „AI Nadzorowane przez Człowieka”, szczególnie w branżach krytycznych (zdrowie, finanse, edukacja).

Przekaz „nasze AI jest nadzorowane przez ludzi” stanie się istotny w budowaniu zaufania – tam, gdzie koszt błędu jest wysoki.

Etyczna AI jako fundament strategii

Głośno komentowane wpadki AI pokazują, jak automatyzacja bez kontroli prowadzi do błędów i utraty reputacji: błędna decyzja kredytowa, stronniczy wyrok, pomyłka w diagnostyce — to prosta droga do kryzysu lub pozwu.

Włókno nadzoru ludzkiego wplatane w AI staje się elementem przewagi — pozwala spełnić regulacje i buduje odpowiedzialność wobec klienta. Etyka to już nie tylko wartość — to wymóg biznesowy.

Certyfikowane systemy i audytowalność

Prawdopodobne są certyfikaty HITL compliance dla AI, podobne do ISO. Oznaki te będą gwarantować możliwość nadzoru i rewizji decyzji przez człowieka.

To przewaga konkurencyjna: przejrzysta, audytowalna AI z nadzorem człowieka przyciągnie zaufanie klientów i regulatorów.

Jak podkreśla NIST AI Risk Management Framework, systemy AI muszą być projektowane z założeniem nadzoru. Human-in-the-loop i human-on-the-loop pozostaną kluczem do minimalizowania ryzyk systemowych i mogą wkrótce być wymogiem prawnym.

HITL od projektowania, nie na doczepkę

Pojęcie „HITL by design” zyska popularność. Zamiast dodawania HITL po fakcie, architektura AI będzie tworzona z ludzką kontrolą od podstaw. To początek ery odpowiedzialnej AI, gdzie przejrzystość i etyka to integralny element produktu.

Liderzy w branży już przyjmują to podejście.

Ostatecznie nie będzie chodziło o walkę człowieka z maszyną, lecz o człowieka współdziałającego z maszyną. — Satya Nadella, CEO Microsoft

To zmienia podejście do produktów — od oprogramowania B2B po technologie konsumenckie.

Do 2030: Człowiek i AI ramię w ramię

Wraz z ekspansją AI przesłanie brzmi: przyszłość należy do tych, którzy łączą automatyzację z ludzką wiedzą.

AI może przynieść światowej gospodarce nawet 15,7 biliona dolarów do 2030 roku wg PwC.

HITL nie będzie reliktem — stanie się filarem etycznych i wyjaśnialnych systemów AI.

Do 2030 roku nadzór człowieka stanie się podstawową regułą projektową AI – obowiązkowym standardem, nie opcją. Firmy, które wdrożą go wcześniej, wypracują przewagę na lata.

Pomyśl, jak pasy bezpieczeństwa — dziś nie wyobrażamy sobie samochodu bez standardowych zabezpieczeń. Tak HITL stanie się oczywisty w każdej poważnej implementacji AI: zabezpieczy użytkowników, wyeliminuje błędy i zagwarantuje inkluzywną innowację.

Czas się przygotować – jak podaje Amazon, do 2030 Europa niemal w pełni zaadoptuje AI.

Liderzy biznesowi i stratedzy IT powinni już dziś:

- Inwestować w narzędzia i interfejsy wyjaśnialne dla AI

- Tworzyć zespoły nadzoru człowieka

- Wybrać platformy ze wsparciem dla przeglądu manualnego

- Budować procesy, w których współpraca AI i człowieka jest regułą

Zaostrzające się regulacje i rosnąca rola zaufania będą wyznaczać fundament odporności, elastyczności i etycznego przywództwa w nadchodzącej dekadzie.

Ostatnia aktualizacja