Qu’est-ce que GIGO ?

GIGO (Garbage In, Garbage Out) est un principe fondamental en informatique, en automatisation et en intelligence artificielle qui signifie que la qualité des résultats dépend entièrement de la qualité des données d’entrée.

À retenir :

- GIGO (Garbage In, Garbage Out) signifie que de mauvaises données produisent toujours de mauvais résultats, quel que soit le système utilisé.

- Des données erronées impactent directement le ROI de l'automatisation à travers des pertes, des risques et une atteinte à la réputation.

- Parseur assure une automatisation fiable grâce à une extraction précise et des contrôles HITL.

Selon Shelf, les entreprises perdent en moyenne entre 12 et 15 millions de dollars par an à cause d’une mauvaise qualité des données, certaines grandes entreprises déclarant des pertes allant jusqu’à 406 millions de dollars chaque année. Pourtant, derrière les promesses séduisantes de ROI, un tueur silencieux sévit : les mauvaises données. En moyenne, cela fait baisser le chiffre d’affaires des entreprises de 12 % et peut faire manquer 45 % des prospects à cause de problèmes comme les doublons, des formats non valides ou des informations de contact obsolètes. Lorsqu'on introduit des données défectueuses dans des workflows automatisés, elles ne restent pas inoffensives : elles se répliquent, générant des problèmes plus graves et plus coûteux en aval.

Quand les systèmes d'automatisation reposent sur des données médiocres, jusqu’à 87 % ne parviennent jamais en production en raison de problèmes de qualité de données non résolus, selon VentureBeat. Ce blocage ne fait pas que freiner les projets : il nuit à la confiance dans l’IA elle-même. Par ailleurs, Huble indique que 69 % des entreprises déclarent que de mauvaises données empêchent toute décision ou analyse fiable par l’IA. C’est le principe fondamental du Garbage In, Garbage Out (GIGO). En résumé, GIGO signifie que si l’automatisation s’appuie sur des données défectueuses, les résultats seront inévitablement peu fiables, même si le système ou l’IA est très avancé.

Aujourd’hui, dans le monde de l’automatisation et de l’IA (GIGO appliqué à l’IA), ce principe n’est plus une mise en garde théorique : c’est une réalité incontournable. Sans données de qualité, l’automatisation devient un amplificateur d’erreurs. Les organisations qui négligent la fiabilité des données n’obtiennent qu’un retour sur investissement limité sur leurs projets d’automatisation.

Qu’est-ce que Garbage In, Garbage Out (GIGO) ?

Le terme Garbage In, Garbage Out (GIGO) remonte aux débuts de l’informatique. Il explique que si un système reçoit des données erronées, incomplètes ou inexactes, ses résultats seront nécessairement défaillants. Un taux d’erreur de seulement 15 % sur les données d’entraînement peut paralyser la performance d’un modèle et mener à des conséquences graves dans certains secteurs, selon Sama. Autrement dit : données médiocres en entrée = résultats médiocres en sortie.

Pourquoi le GIGO est-il crucial aujourd’hui ?

À l’ère de l’IA et de l’automatisation, les enjeux sont nettement plus élevés. Alors qu’un bug classique pouvait fausser un rapport ou un calcul isolé, dans les systèmes d’automatisation modernes, une petite erreur se propage et s’amplifie. Par exemple :

- Une date de facture mal lue peut occasionner des milliers de paiements retardés.

- Un biais dans les données d’entraînement de l’IA génère des prédictions biaisées à grande échelle.

- Un identifiant client incohérent sème la confusion dans l’ERP, le CRM et les plateformes de support.

GIGO avant vs. GIGO maintenant

- Informatique traditionnelle : Saisir de mauvaises données dans un logiciel ou une calculatrice donnait une réponse fausse mais localisée.

- Automatisation/IA moderne : Les données défectueuses se propagent dans les workflows, bases de données et processus métiers. Les erreurs se multiplient, les risques réglementaires explosent et le ROI s’écroule.

Le coût des mauvaises données dans l’automatisation

Les données de mauvaise qualité ne sont pas un simple désagrément : elles font s’écrouler le ROI de l’automatisation. Gartner estime que la mauvaise qualité de données coûte en moyenne 12,9 millions de dollars par an aux organisations. Injecter ces données dans des workflows automatisés sans contrôles humains ne fait qu’étendre les erreurs et accroître considérablement les coûts et les risques.

Principaux risques pour l’entreprise

Factures incorrectes → pertes financières

Une facture erronée ou en double cause des trop-perçus, des retards de paiement, voire des écarts comptables.

Données logistiques erronées → livraisons bloquées

Une adresse incorrecte, un code postal manquant ou des champs incohérents retardent l’acheminement et détériorent la relation client.

Erreurs dans les données patient → non-conformité et mise en danger

Dans la santé, des identifiants patients inexacts ou des dossiers incomplètement synchronisés augmentent le risque de non-conformité (HIPAA) et menacent la sécurité du patient.

Comment les mauvaises données épuisent le ROI de l’automatisation

- Investissements perdus → Les coûts des projets IA, RPA et d’automatisation restent stériles si la donnée source est défaillante.

- Multiplication des tâches de nettoyage → Les équipes consacrent jusqu’à 80 % de leur temps à nettoyer les données au détriment de la création de valeur.

- Sanctions réglementaires → Dans les secteurs soumis à des normes, la moindre erreur peut entraîner sanctions, litiges ou audit défavorable.

- Perte de confiance → Clients, organismes de régulation et collaborateurs doutent des systèmes truffés d’erreurs.

À retenir : Sans corriger la qualité des données, l’automatisation ne produit pas des gains d’efficacité ; elle en accélère les risques et coûts.

Sources fréquentes de données erronées

Dans l’automatisation, les mauvaises données ne constituent pas qu'un inconvénient, elles affectent directement la rentabilité des processus. Là où l’on imagine que les erreurs graves sont rares, Zipdo démontre que près de 70 % des données en entreprise sont jugées "sales" ou peu fiables. Suffisant pour faire dérailler des processus automatisés entiers.

Principales sources de mauvaises données en automatisation :

Saisie manuelle

Erreurs typographiques, champs manquants ou mauvaises séparations perturbent la comptabilité, la conformité ou le suivi.

Outils OCR peu performants

Documents de qualité médiocre, écritures manuscrites, fichiers flous : l’OCR peut confondre chiffres et lettres (ex : “5” et “S”), entraînant des données erronées.

Doublons et formats hétérogènes

Un même client saisi sous différentes variantes ("Acme Corp", "Acme Inc.") provoque des doublons, de la confusion et de mauvaises analyses.

Absence de contrôles à l’ingestion

L’absence de règles de validation (format de date, code pays, intégrité des champs) laisse passer des enregistrements invalides qui feront échouer l’automatisation.

Consultez notre guide détaillé sur la qualité des données en automatisation.

Pourquoi l’automatisation ne corrige pas les mauvaises données (elle les amplifie)

Une illusion répandue dans la transformation numérique consiste à croire que l’automatisation va “nettoyer” automatiquement les bases de données. Or, l’automatisation ne filtre pas : elle accélère. Tout ce qu’elle reçoit sera traité plus vite… pas forcément corrigé. En 2025, 64 % des organisations citent la qualité des données comme premier challenge d’intégrité et 77 % jugent leur niveau moyen ou insuffisant, selon Precisely. Résultat : la plupart des automatisations propagent les erreurs au lieu de les corriger.

- Exemple finance : Un montant de facture mal extrait par OCR ne sera jamais questionné par l’automatisation : le paiement erroné sera fait… à grande échelle.

- Exemple logistique : Une mauvaise adresse dans la base peut impacter des milliers d’expéditions, avec retards, coûts supplémentaires et clients mécontents.

- Exemple IA : Les modèles de langage, eux, s’appuient strictement sur les données reçues. Biaisées, incomplètes ou fausses, ils les répliquent massivement dans leurs résultats.

Voilà tout l’enjeu du GIGO en automatisation : une seule petite erreur à l’entrée peut provoquer un désastre en sortie.

GIGO dans l’IA : risques accrus

Le principe “Garbage in, garbage out” prend une ampleur inédite avec l’automatisation pilotée par l’IA. Contrairement aux systèmes classiques, les modèles IA fonctionnent souvent comme des “boîtes noires” : la logique n’est pas toujours traçable. La qualité des données d’entraînement et d’entrée devient alors vitale.

Pourquoi le GIGO appliqué à l’IA est si risqué :

- Opacité des modèles → En cas de problème, il est difficile de remonter et d’identifier la donnée d’origine en cause.

- Propagation des biais → Des ensembles de données incomplets ou déséquilibrés génèrent des biais persistants, de l’étude de crédit au recrutement automatisé.

- Risque réglementaire → Dans les domaines sensibles, une IA mal entraînée ou exploitant des données non conformes peut entraîner sanctions RGPD, violations HIPAA, ou audits négatifs.

- Dégradation de l’image → Décisions illogiques, résultats incohérents ou partialité font fuir clients et partenaires.

Le garde-fou : Human-in-the-Loop (HITL)

L’intégration HITL (humain dans la boucle) instaure un contrôle indispensable sur les workflows IA. La validation humaine des extractions douteuses, la vérification ponctuelle de cas sensibles ou la correction d’anomalies contextuelles limite les dérives automatisées.

Le modèle hybride, associant automatisation et supervision HITL, garantit une IA plus fiable, compréhensible et conforme, et instaure une véritable maîtrise des risques.

Prévenir GIGO : méthodes clés

La bonne nouvelle : le GIGO dans l’automatisation peut être maîtrisé. En déployant standards, modèles et contrôles adaptés, chaque organisation peut automatiser sur une base de données robuste et de confiance.

1. Appliquer la méthode VACUUM

Le modèle VACUUM (Valide, Accurate, Cohérent, Uniforme, Unifié, Modélisé) forme une checklist d’excellence pour bâtir une donnée fiable et exploitable à travers tous les systèmes.

2. Utiliser les standards ECCMA

L’Electronic Commerce Code Management Association (ECCMA) propose des standards internationaux pour structurer, qualifier et échanger les données. S’y conformer assure cohérence, qualité et conformité pour les machines et les équipes.

3. Valider automatiquement et gérer les exceptions

Mettez en place des contrôles automatisés dès l’ingestion : validation des montants, des champs, des formats de date. Ajoutez une gestion des exceptions pour qu’aucune anomalie ne franchisse la chaîne sans alerte.

4. Intégrer la supervision Human-in-the-Loop (HITL)

Même avec des technologies avancées, la supervision humaine reste indispensable sur les processus critiques ou réglementés. Elle permet de contrôler les cas limites, les situations ambiguës et de garantir que les données sensibles sont validées avant automatisation.

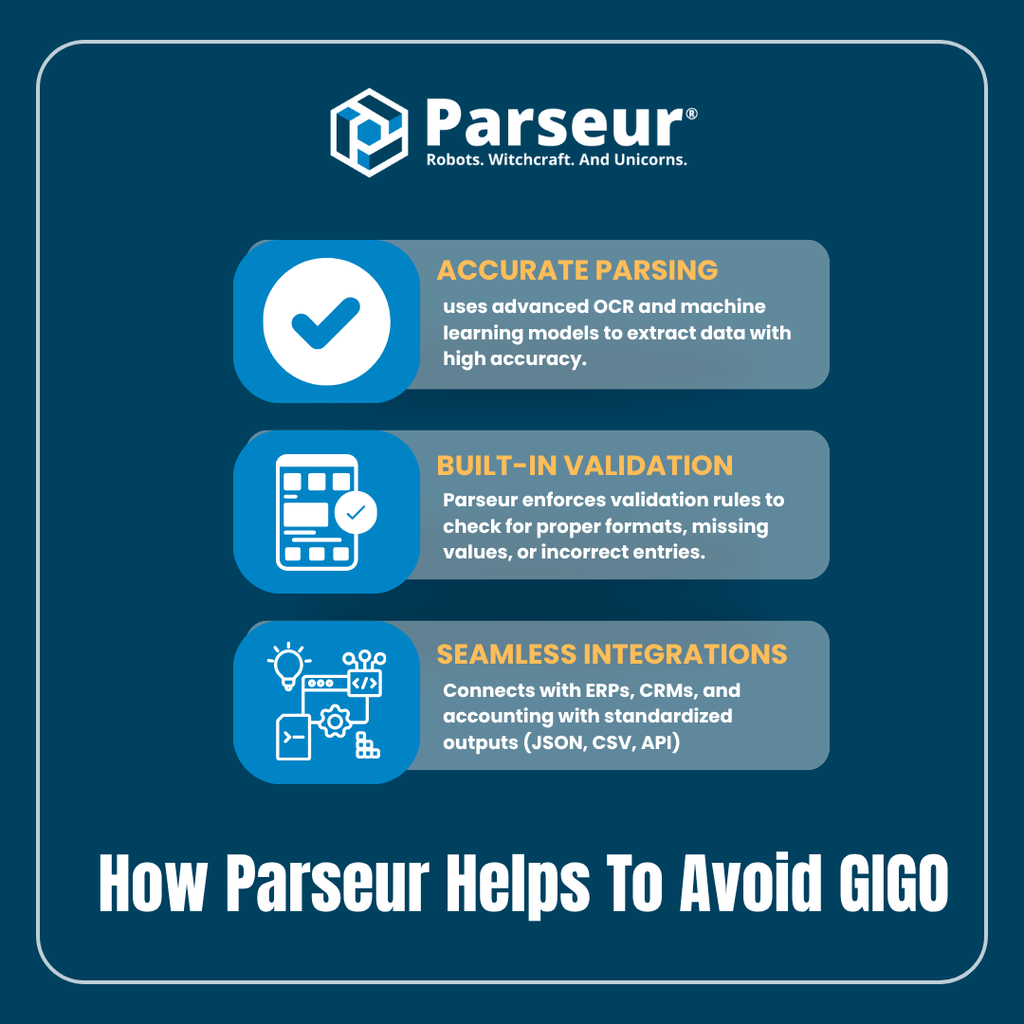

Comment Parseur aide à éviter GIGO

Le principe Garbage In, Garbage Out (GIGO) alerte sur les risques de données défaillantes, mais comment y remédier au quotidien ? Parseur apporte une réponse complète et concrète.

1. Extraction précise avec OCR intelligent et machine learning

Parseur s’appuie sur des modèles avancés d’OCR et de machine learning pour extraire les données de documents (factures, emails, tickets, bordereaux ou formulaires) avec une haute fiabilité, adaptés à chaque secteur. Cela réduit les erreurs classiques comme les champs inversés ou la mauvaise reconnaissance de caractères.

2. Règles de validation et normalisation intégrées

Au-delà de l’extraction, Parseur applique des règles de validation pour repérer les formats atypiques, champs vides ou incohérences. Exemples :

- Vérification des dates sous format ISO (AAAA-MM-JJ)

- Uniformisation des devises (ex : “USD” au lieu de “$” ou “US Dollars”)

- Contrôle de concordance entre le total et les lignes de facturation

Cela assure une donnée harmonisée entre tous les systèmes.

3. Intégrations fluides inter-systèmes

Parseur exporte vos données directement vers vos outils métiers (ERP, CRM, comptabilité), en adaptant la sortie aux formats standards (CSV, Excel, JSON, API…). Cela prévient les erreurs de synchronisation sur l’ensemble de votre chaîne d’automatisation.

Construire une automatisation fiable et évolutive

Garbage In, Garbage Out (GIGO) n’est pas un simple concept technique : c’est l’élément qui fait la différence entre échec et succès en automatisation. Peu importe le degré d’avancement des IA ou RPA, l’automatisation ne sera jamais meilleure que la qualité de la donnée d’entrée. Ignorer ce principe, c’est s’assurer des surcoûts, des risques et la perte de confiance des parties prenantes.

Les entreprises qui investissent dans la qualité des données maximisent l’impact de leur automatisation : elles bénéficient de résultats fiables, exploitables et robustes à grande échelle.

Avec Parseur, il n’est plus nécessaire de choisir entre rapidité et fiabilité. Notre parsing intelligent, nos validations intégrées et — lorsque c’est nécessaire — notre supervision humaine, assurent que vos workflows automatisés reposent sur une donnée de confiance. L’automatisation devient ainsi un moteur de ROI durable, de croissance et de crédibilité auprès de vos clients, équipes et régulateurs.

Foire Aux Questions

Même si GIGO est un principe simple, de nombreuses entreprises sous-estiment encore son impact sur le ROI de l'automatisation. Ces réponses rapides traitent des questions les plus fréquemment posées.

-

Que signifie Garbage In, Garbage Out (GIGO) dans l'automatisation ?

-

Cela signifie que des données de mauvaise qualité produisent inévitablement des résultats peu fiables, quel que soit le niveau d’avancement ou le coût du système. L’automatisation ne corrige pas les erreurs ; elle les amplifie.

-

Pourquoi le GIGO est-il plus dangereux dans les workflows d’IA ?

-

Parce que l’IA et le machine learning amplifient les erreurs à grande vitesse. Avec des modèles opaques (« boîtes noires »), des données de formation biaisées ou de mauvaise qualité peuvent générer des erreurs majeures, fausser les analyses, voire mener à des non-conformités, souvent sans signes d’alerte évidents.

-

Comment de mauvaises données affectent-elles le ROI de l’automatisation ?

-

Des données de mauvaise qualité consomment des ressources et génèrent des erreurs coûteuses. Des études montrent que les entreprises perdent 15 à 25 % de leur chiffre d'affaires chaque année à cause des problèmes de données, tandis que les projets d'automatisation gaspillent jusqu'à 80 % de leurs efforts à nettoyer des données au lieu de créer de la valeur.

-

Peut-on éviter le GIGO ?

-

Oui. Les organisations peuvent construire des pipelines de données fiables en appliquant des cadres structurés comme le modèle VACUUM, en adoptant des normes mondiales telles qu’ECCMA, en mettant en place des contrôles de validation automatisés et en ajoutant des vérifications humaines (HITL) pour les cas limites.

-

Comment Parseur aide-t-il à prévenir le GIGO ?

-

Parseur combine un parsing alimenté par l’IA, des validations intégrées et un contrôle HITL pour garantir que seules des données propres, standardisées et fiables alimentent votre pile d’automatisation. Cela transforme l’automatisation d’un potentiel amplificateur de risques en un moteur de croissance sûr et fiable.

Dernière mise à jour le