Points clés à retenir

- Les limites de l’OCR restent un goulot d’étranglement majeur dans le traitement de documents. Même les moteurs évolués rencontrent encore des difficultés avec l’écriture manuscrite, les scans médiocres ou les polices stylisées, aboutissant à la perte de jusqu’à 36 % des données clés si l’on n’emploie pas de techniques de parsing avancées.

- Les modèles rigides cassent facilement dès que le format du document évolue. Les plateformes de parsing boostées par l’IA, telles que Parseur, proposent des solutions hybrides capables de suivre les évolutions de mise en page, limitant les ruptures de flux et la reprise coûteuse manuelle.

- Des champs critiques peuvent disparaître à cause d’intitulés incohérents ou de logiques de parsing reposant trop sur la position au lieu du contexte. L’extraction basée sur l’IA, sensible au contenu, améliore la reconnaissance des champs sur des types de documents variés.

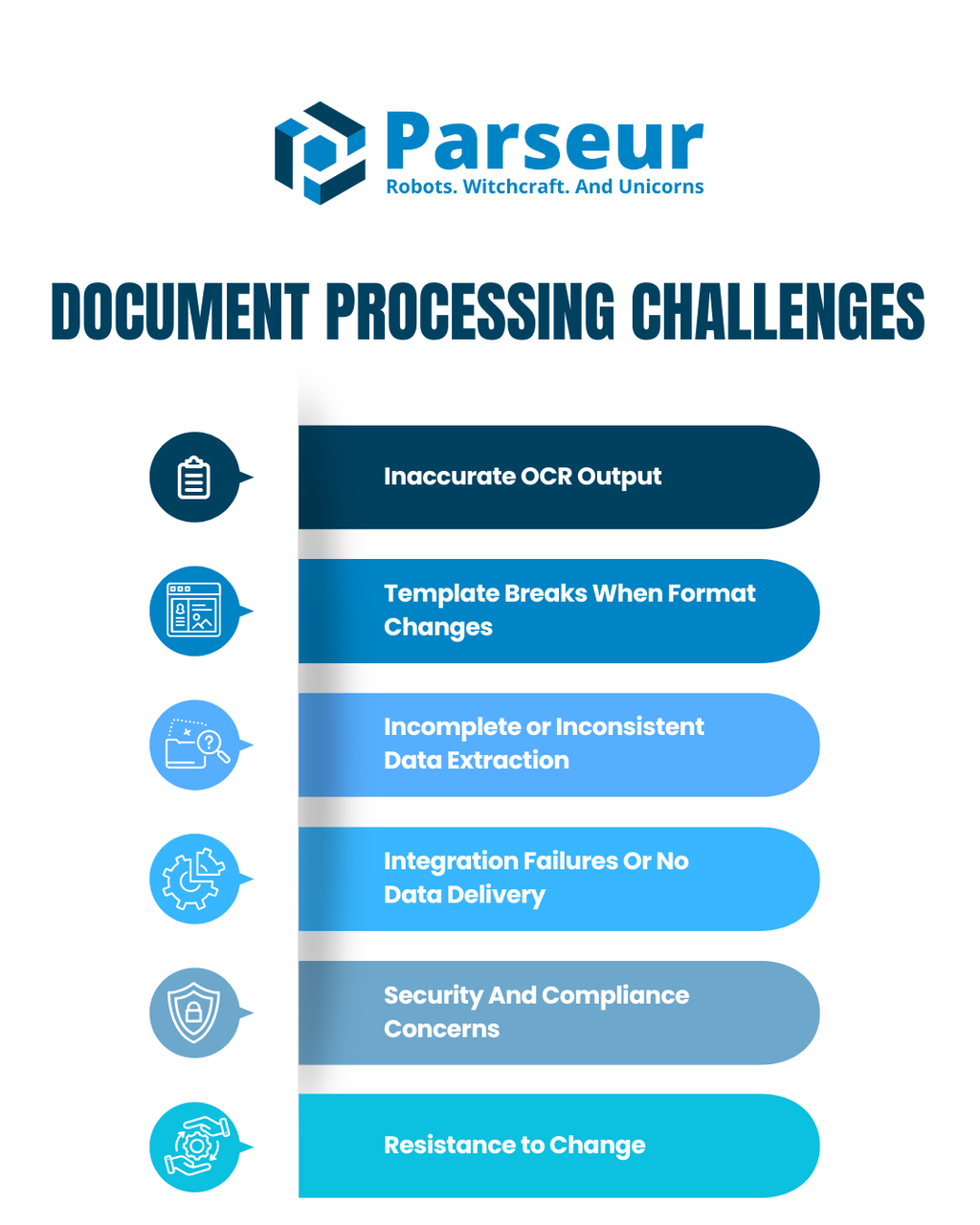

Automatiser le traitement des documents peut vous faire gagner des heures de saisie manuelle et faire bondir la précision. Mais de nombreuses équipes l’ont appris à leurs dépens : tout n’est pas si simple.

Des échecs d’OCR aux modèles cassés et aux intégrations ratées, les défis du traitement documentaire peuvent gripper même les workflows d’automatisation les plus prometteurs.

Une statistique rapportée par File Center fait état d’un rapport de M-Files de 2025, relayé par FileCenter.com. Ce rapport indique que 66 % des entreprises rencontrent des difficultés majeures lors de l’approbation et la révision de documents, principalement à cause de processus manuels de signature papier qui rallongent les circuits et complexifient la collaboration. Cela illustre combien des workflows documentaires inefficaces freinent encore la réussite de l’automatisation et l’efficacité opérationnelle.

La bonne nouvelle ? La plupart des problèmes possèdent des solutions simples et concrètes, dès lors qu’on sait où chercher.

Dans cet article, nous parcourons cinq des principaux défis du traitement documentaire. Pour chacun, nous expliquons ce qui cloche, pourquoi cela arrive et comment le corriger efficacement. Vous repartirez avec des conseils pratiques, immédiatement applicables, et connaîtrez moins de tracas sur le long terme.

Si vous débutez, consultez notre guide : Qu'est-ce que le traitement de documents ?

Défi 1 : Résultats OCR imprécis

L’OCR (Reconnaissance Optique de Caractères) est l’un des piliers de l’automatisation documentaire. C’est cette technologie qui permet à votre système de “lire” vos documents scannés pour les transformer en données structurées. Mais, bien que l’OCR soit puissant, il reste loin d’être infaillible. Quand l’outil lit mal un document, cela déclenche toute une cascade d’erreurs, de retards et de corrections à la main.

Beaucoup d’organisations pensent que l’OCR convertira parfaitement n’importe quel document scanné en données exploitables. En réalité, même les meilleurs outils peinent sur des documents flous, inclinés ou affichant des polices inhabituelles ou des annotations manuscrites. Ce qui reste parfaitement lisible pour un humain ressortira parfois méconnaissable de l’OCR : symboles incohérents, sections absentes, lignes déformées.

Problème :

Les outils OCR renvoient souvent du texte illisible, des caractères manquants ou des données mal formatées. On observe aussi des symboles bizarres, des champs absents ou décalés perturbant la suite du traitement.

Causes principales :

- Scans de mauvaise qualité. Les OCR ont du mal avec les images floues, en basse résolution ou déformées, en particulier en présence d’ombres ou de bruit de fond.

- Polices inhabituelles ou stylisées. Les polices décoratives déstabilisent les OCR classiques, souvent entraînés sur des typographies basiques.

- Manuscrits, tampons et annotations. La saisie manuscrite ou les contenus atypiques résistent à la plupart des moteurs OCR du marché.

Solutions :

- Prétravaillez vos images. Améliorer la qualité des scans (redimensionnement, ajustement du contraste, correction de l’orientation) améliore significativement les performances de l’OCR.

- Utilisez des moteurs OCR avancés. Des outils comme Parseur et Tesseract offrent une détection de meilleure qualité, surtout si vous les couplez avec une plateforme intelligente telle que Parseur qui enrichit l’OCR via l’IA intégrée.

- Entraînez votre système sur les structures habituelles. Fournir du contexte sur les types de documents ou leur mode d’organisation facilite la reconnaissance et limite les erreurs.

Les systèmes OCR modernes atteignent environ 80 à 85 % de précision sur des documents bien imprimés. Toutefois, cette précision chute fortement sur l’écriture manuscrite ou les documents de qualité médiocre : la reconnaissance manuscrite plafonne à 64 % de réussite en moyenne. Cette variabilité du rendu OCR reste un défi critique qui perturbe les flux automatisés et impose de fréquentes corrections manuelles, comme le rappelle Octaria.

Au final, la qualité de votre OCR dépend largement des documents que vous lui fournissez. Investir dans de meilleurs scans, des outils plus puissants et des techniques de prétraitement génère de meilleurs taux de réussite et limite la correction manuelle.

Défi 2 : Les modèles cassent quand le format change

Les templates sont idéaux quand les documents restent stables. Ils permettent d’extraire facilement des données sur des formats récurrents : factures, reçus, bons de livraison, etc. Mais dans la réalité, la mise en page évolue souvent sans prévenir. Un fournisseur déplace une colonne, modifie un libellé ou réorganise des champs… et soudain, votre template ne fonctionne plus.

Le moindre ajustement peut entraîner une perte totale d’extraction. Plutôt qu’un flux fluide, les équipes doivent souvent suspendre l’automatisation pour retoucher manuellement les règles… bien souvent dans l’urgence.

Problème :

Un template fonctionne un jour, puis cesse d’extraire les données dès qu’un fournisseur change la mise en page ou l’ordre des champs.

Causes principales :

- Templates figés sur la position. Si la structure est modifiée ne serait-ce qu’un peu, le parseur perd les repères et ne trouve plus les bons champs.

- Règles manuelles fragiles. Les réglages codés main conviennent à un format, mais ne suivent pas le rythme des changements, surtout avec des documents de nombreuses origines différentes.

- Aucune flexibilité structurelle. La plupart des systèmes à règles n’offrent ni logique de secours ni adaptation “intelligente” aux nouveaux layouts.

Solutions :

- Passez à un parsing hybride ou IA. Ces systèmes détectent les données via le contenu, les libellés ou le contexte, non une position fixe.

- Employez des champs flexibles ou smart zones. Ces zones dynamiques s’ajustent lorsque les textes ou espacements varient d’un document à l’autre.

- Essayez une plateforme comme Parseur. Elle combine template et IA pour comprendre les motifs de champs, garantissant que votre flux ne casse pas en cas de changement de mise en page.

Accenture, l’un des plus grands cabinets mondiaux, traite plus d’un demi-million de factures clients par an et a rencontré de nombreux échecs d’automatisation liés à ses templates internes : jusqu’à 30 % des factures étaient rejetées lors de la première tentative à cause d’incompatibilités de modèles.

Quand les templates cassent, les équipes perdent du temps à diagnostiquer et retraiter les documents à la main, menant à des retards, une perte de productivité et une défiance croissante envers l’automatisation. L’adoption de stratégies de parsing plus adaptatives vous garantit un système opérationnel, même lorsque les documents changent régulièrement.

Défi 3 : Extraction incomplète ou incohérente des données

Même lorsque les documents sont bien lus, extraire les bons champs en continu est un problème fréquent. Les erreurs arrivent souvent quand :

- Les intitulés varient selon le document (ex : “Montant dû” vs “Total”)

- Une donnée apparaît à plusieurs endroits ou dans différents contextes

- Les règles d’extraction reposent sur une logique fragile de mise en page

Résultat : des vides de données, des erreurs de classement ou des entrées incohérentes, notamment dans la logistique, l’assurance, ou la finance où la diversité des formulaires est élevée.

Causes principales :

- Le parseur ne sait pas quoi extraire. L’OCR lit bien le texte, mais si votre outil de parsing n’est pas instruit pour le capturer, l’information est ignorée.

- Incohérences dans les libellés. Plusieurs documents emploient des intitulés différents pour le même champ (ex : « Client », « Acheteur », « Société »), ce qui déroute les parseurs à règles.

- Variations de mise en page. Un champ décalé ou associé à un contenu annexe peut échapper aux règles classiques.

Solutions :

- Mappez manuellement les libellés alternatifs. Paramétrez votre parseur pour repérer toutes les variantes de chaque donnée clé.

- Utilisez du parsing IA sensible au contexte ou aux mots-clés. Le système détectera les champs sur la base du contenu et du contexte, et non plus uniquement de la position.

- Ajoutez une logique de détection de secours. Paramétrez des alertes ou des contrôles manuels lorsque les scores de confiance baissent sous un seuil critique, afin de garantir la supervision humaine au besoin.

- Recherchez des plateformes de traitement documentaire combinant parsing IA et logique par règles, pour assurer l’interprétation des formats même inconnus ou irréguliers.

Si vous passez encore trop de temps à corriger ou reparsing des documents, c’est le signe que votre configuration mérite d’être affinée. Une meilleure reconnaissance des champs et une validation intelligente réduisent sensiblement le besoin de contrôles manuels.

Défi 4 : Échecs d’intégration ou absence de livraison des données

C’est l’un des problèmes les plus frustrants pour toute équipe s’appuyant sur l’automatisation pour transférer des infos vers Google Sheets, CRM ou comptabilité. Tout paraît tourner… jusqu’à ce que plus rien n’arrive à destination.

Le parsing fonctionne, mais si l’étape finale échoue, tout le flux est bloqué. Qu’il s’agisse d’une erreur de webhook, d’un souci d’API ou d’un bug de la plateforme d’automatisation, la conséquence est toujours : donnée perdue et relance manuelle.

Problème :

Les données sont bien parsées mais n’atteignent pas la cible attendue (tableur, base de données, appli connectée…).

Causes principales :

- URL de webhook incorrecte ou mal configurée, entraînant une livraison manquée

- Erreurs dans les connecteurs tiers (Zapier, Make…) : tâches ignorées ou mal aiguillées

- Problèmes d’API : quota dépassé, format de donnée erroné, token expiré

- Timeout du webhook

Solutions :

- Testez votre intégration avec des documents de test avant la mise en service pour vérifier le mapping et la bonne livraison.

- Privilégiez des outils capables de relancer les livraisons ratées et de fournir un suivi du transfert, comme Parseur.

- Déployez des mécanismes de secours – alertes email, surveillance du statut des webhooks – pour que l’équipe soit prévenue si souci.

Selon IRJMets, 1 240 projets d’automatisation documentaire dans des secteurs variés (santé, finance, industrie) révèlent que 41,7 % de tous les échecs d’intégration en entreprise sont dus à des incohérences de format des documents et à des erreurs lors de la transformation des données entre systèmes.

Des intégrations qui échouent créent une rupture entre l’extraction et l’utilisation de la donnée. Les équipes perdent du temps à rechercher l’erreur, reparsing les documents, contrôler les fichiers – tout cela réduit la valeur de votre automatisation.

Défi 5 : Sécurité et conformité

Les secteurs les plus réglementés (santé, banque, logistique…) exigent un contrôle sans faille sur le stockage, la circulation et l’accès aux données. Utiliser des outils qui ne sont pas conformes aux référentiels RGPD, HIPAA ou SOC 2 expose à de vrais risques juridiques et réputationnels.

Une manipulation imprudente de documents contenant des informations personnelles (PII), de santé ou bancaires peut se traduire par de lourdes conséquences juridiques et d’image. Les équipes ont besoin de garanties que les outils respectent des standards rigoureux de sécurité et de conformité.

Problème :

L’équipe hésite à téléverser ou traiter des documents sensibles via l’automatisation, en raison de craintes autour de la confidentialité, de l’hébergement cloud ou de la conformité réglementaire.

Causes principales :

- Flou sur l’emplacement des données et sur leur chiffrement

- Peu de visibilité sur les certifications ou la sécurité de l’infrastructure des prestataires

- Contraintes réglementaires spécifiques : RGPD, HIPAA, CCPA demandant des protocoles stricts

Solutions :

- Utilisez des plateformes de gestion documentaire qui s’appuient sur une infrastructure cloud certifiée : conformité SOC 2, ISO 27001 ou HIPAA.

- Vérifiez que l’outil propose un chiffrement de bout en bout (stockage et transit) ainsi qu’un contrôle précis des accès.

- Privilégiez des outils proposant un hébergement régional conforme à la souveraineté locale (hébergement UE ou US dédié…)

- Optez pour des solutions telles que Parseur, qui garantit une haute disponibilité (99,99 %), des mécanismes de relance des livraisons et des pratiques de sécurité transparentes.

En 2024, le rapport IBM sur le coût d’une violation de données a montré que le coût mondial moyen d’une violation avait atteint 4,88 millions de dollars, soit une hausse de 10 %, la plus forte progression annuelle depuis la pandémie. Cette envolée rappelle la pression croissante sur la sécurité et doit inciter toute organisation qui automatise ses documents à prioriser la conformité et la robustesse.

Défi 6 : Résistance au changement

Même avec les meilleurs outils d’automatisation du monde, l’adoption repose en grande partie sur… les humains. Si l’équipe ne fait pas confiance, ou si le système est mal compris, chacun gardera ses routines manuelles aussi inefficaces soient-elles. Résister au changement est humain, surtout si l’automatisation paraît être une menace ou une difficulté plutôt qu’une aide.

Problème :

Malgré le déploiement d’une solution automatisée pour la gestion documentaire, les employés persistent à copier-coller, envoyer les emails, ou ressaisir les données manuellement. Cela ralentit le retour sur investissement, crée des incohérences et sous-exploite l’automatisation.

Causes principales :

- Manque d’implication : Le personnel n’a pas été consulté ou impliqué dans le déploiement, donc personne ne s’approprie la démarche.

- Craintes pour l’emploi : L’automatisation est souvent vue comme une source d’inquiétude plutôt qu’un outil d’appui.

- Manque de formation : Les utilisateurs ne savent pas utiliser l’outil ou n’ont pas saisi l’intérêt d’abandonner leurs anciennes méthodes.

- Fatigue logicielle : Des expériences passées complexes ou négatives freinent l’adoption.

Solutions :

- Impliquez les membres de l’équipe en amont dès la conception et les tests, pour recueillir leur avis et favoriser l’adhésion. Quand les utilisateurs participent à la création du flux de travail, ils s’engagent plus facilement.

- Organisez des démos, compagnonnages et formations adaptées à chaque profil, pour rendre la montée en compétences simple, sans stress.

- Représentez l’automatisation comme un assistant, pas comme une menace : c’est l’outil qui fait les tâches répétitives afin que vos collègues se concentrent sur l’analyse, la décision ou la résolution créative.

- Célébrez chaque succès : montrez concrètement comment l’automatisation a supprimé un irritant, économisé du temps ou évité une erreur. Multipliez ce type d’exemples pour inspirer la confiance.

- Privilégiez l’ergonomie et l’UX : sélectionnez des outils à l’interface claire, aux instructions limpides et au support réactif. Une mauvaise expérience utilisateur provoque plus de résistance que l’automatisation elle-même.

L’adoption n’est jamais immédiate. Il faut du temps, du dialogue et du suivi. Mais, en montrant que l’automatisation facilite (et non complique) la vie au quotidien, l’équipe finira par accrocher.

Surmonter les défis du traitement de documents commence par la bonne fondation

L’automatisation du traitement documentaire offre la promesse de workflows plus rapides, de moins d’erreurs et de gains d’échelle – mais uniquement si l’on attaque les défis structurels de front. Entre limites de l’OCR, templates trop rigides, échecs d’intégration ou exigences de conformité, ces freins invisibles peuvent grignoter l’efficacité attendue de l’automatisation.

La bonne nouvelle ? Ces écueils ne sont jamais des impasses techniques : ils indiquent, au contraire, qu’il est temps de faire évoluer ses pratiques.

Des solutions comme Parseur sont pensées pour dépasser ces blocages en combinant parsing boosté à l’IA, modèles flexibles, intégrations transparentes et sécurité de niveau entreprise sur une seule plateforme. Que vous traitiez des factures, contrats ou documents logistiques, Parseur transforme la complexité en simplicité, sans code ni maintenance continue.

Foire Aux Questions (FAQ)

Voici les questions les plus fréquemment posées sur le traitement de documents.

-

Pourquoi mon OCR échoue-t-il souvent ?

-

L’OCR échoue généralement à cause de scans de qualité médiocre, de polices non standards ou de contenu manuscrit. Les images en basse résolution, les ombres et les angles inclinés peuvent perturber les moteurs de reconnaissance optique de caractères (OCR). Pour améliorer les résultats, privilégiez des scans propres, prétraitez vos images autant que possible, et sélectionnez des outils OCR avancés incluant des améliorations par l’IA.

-

Pourquoi l’extraction des données manque-t-elle de fiabilité ?

-

Les erreurs d’extraction proviennent généralement de modèles qui dépendent trop de la mise en page exacte. Si un intitulé se déplace ou évolue, l’outil peut ne plus le reconnaître. L’extraction peut également échouer lorsqu’on gère de nombreux types de documents provenant de sources diverses. Passer à un parsing contextuel et utiliser des zones intelligentes (« smart zones ») permet d’atténuer ces problèmes.

-

Comment réparer mes modèles défaillants ?

-

Commencez par contrôler si la structure du document a changé. Si oui, adaptez le template ou passez à une approche hybride qui utilise l’IA pour repérer les champs sur la base du contexte. Des outils comme Parseur proposent un parsing adaptatif qui combine templates et machine learning, rendant le système beaucoup plus tolérant aux changements de mise en page.

-

Les outils d’automatisation garantissent-ils la sécurité et la conformité ?

-

Oui, mais tous les outils ne se valent pas. Privilégiez les plateformes dotées d’une infrastructure cloud sécurisée, de chiffrement et d’un hébergement régional. Les certifications telles que SOC 2 et ISO garantissent la conformité au RGPD, à la HIPAA, et à d’autres normes similaires. Parseur assure une automatisation sécurisée avec 99,99% de disponibilité et des contrôles d’accès robustes.

Dernière mise à jour le