要点总结

- 人参与环AI(HITL)将AI与人工监督相结合,有效提升准确性与公平性。

- 工作流程包括数据标注、模型预测、人工纠正和模型优化,形成反馈闭环。

- HITL广泛应用于文档处理、客户支持、医疗诊断和欺诈检测等领域。

- HITL提供更好的把控力,但相比全自动化,速度更慢且难以扩展。

什么是人参与环AI?

**人参与环AI(Human-in-the-Loop AI, HITL)**是一种在AI系统关键环节引入人工反馈或监督的人工智能方法。简单来说,就是在AI决策过程中,人类持续参与审核、引导和纠正,以提升系统的准确性、公平性和总体表现。

麦肯锡报告显示,企业正迅速部署AI,但随着AI发展,治理和风险管理变得更为重要。随着71%企业如今使用生成式AI,人参与环AI(HITL)的作用变得尤为关键。

与让AI完全自主不同,HITL系统始终保留人工介入,尤其在涉及判断、伦理或质量管控等至关重要的领域。

这种方法通常应用于机器学习模型训练、输出验证以及基于持续反馈的系统优化。它对于医疗、金融、法律服务或大规模文档处理等,任何一次决策都关联现实后果的行业尤其有价值。

HITL也是实现高效人机协作的关键部分,可确保AI工具除了实现自动化以外,还能输出符合人类价值观、业务目标和合规标准的成果。

Clanx数据指出,81%的企业高管认为人参与环AI对其组织非常重要。

欢迎访问我们的人参与环AI:定义、优势与2026趋势,深入了解HITL在AI发展中的基础作用、优势、实施策略及未来趋势。

人参与环AI是如何运作的?

HITL AI将人工深度融入AI开发和决策流程。这一协作模式使人类能在关键阶段主导、审核与优化AI输出,从而确保结果的准确、公正和多维理解。不同于单独训练部署一个AI模型,HITL打造持续反馈回路,使人类在系统优化过程中扮演不可替代的作用。

人参与环AI(HITL)建立了持续、迭代的人机反馈环路。人工在关键阶段引导AI,可将准确率提升高达40%(Eyt),远超纯自动化水平。

典型HITL流程如下:

- 数据标注:人工专家为原始训练数据贴标签或分类,帮助AI明确需要学习的对象。例如在文档解析系统中,人工会标注发票的日期、金额、供应商等,教会AI准确识别这些字段。

- 模型预测:训练完成后,AI根据所学数据生成预测或做出判断,如识别交易模式或从邮件、扫描件中提取信息。

- 人工反馈:人员对AI输出进行评估,指出不准确之处、纠正错误或提出改进建议。人工输入能补充AI容易遗漏的背景和上下文。

- 模型优化:AI根据收到的反馈,重新训练或调整行为。经过多轮迭代,系统在复杂细分任务上的准确性和可靠性持续提升。

部分高级HITL系统采用主动学习,即AI主动发现不确定、难以自判的案例,主动请求人工介入,将人工检查集中在最有价值的部分,进一步提高效率。

即便AI系统上线,在医疗、金融、法律审核等高风险领域,人工监督依然长续存在。持续的人机协作让企业在享受AI高效与可扩展性的同时,关键处保持人工可控。

人参与环AI应用场景

HITL AI广泛适用于对可靠性、公平性和安全性有高要求的各行业。在需要兼顾自动化与可追溯责任的环境,这一方法尤其突出价值。

Expert Beacon数据显示,集成人工反馈的图像分类准确率从91.2%提升到97.7%,明显体现了HITL对模型表现的显著提升。

下面是HITL带来实际价值的典型应用场景:

HITL提升文档处理准确率

AI系统可从发票、收据、合同、表单等非结构化文档中抽取结构化信息。虽然AI能自动处理大多数内容,关键字段如金额、供应商、日期等仍需人工复查校正,以确保数据质量、防止造成高昂损失。HITL对追求高合规性和自动化的业务流程尤为关键。

人机协作提升客户支持效率

不少企业采用AI机器人自动回应常见客户问题,减轻人工压力。但遇到情感复杂、有特殊需求的情况,系统则会自动转交人工坐席处理。该组合让客户体验兼具效率与人性,确保棘手难题得到妥善解决。

HITL保障医疗诊断精准性

医疗行业利用AI分析医学影像或实验数据、快速预警异常(如X光肿瘤),但最终解读与诊断需临床医生复核裁定。AI模型有助于减少漏报误报,切实保证患者安全,关键决策环节需HITL不可替代。

人工监督提升AI反欺诈能力

AI可批量扫描交易,甄别可疑行为,但并非所有预警都属欺诈。人工合规人员负责复查高风险警报、判定最终结果,防止正常客户被误伤。金融机构通过分层审核,兼顾速度与精准度。

自动驾驶场景下的人参与环

半自动驾驶系统下,AI负责导航及环境感知,但在高风险或不确定场景,人类可及时接管。该HITL安全机制保障车辆可面对突发状况灵活响应。

人机结合提升内容审核合规性

AI可自动识别仇恨言论、垃圾内容、虚假信息,但对于边界模糊或需背景判断的个案依赖人工复核,以防误伤与侵权,兼顾平台规范与用户权益。

这些案例说明,HITL帮助企业兼顾效率与责任。通过引入人工于关键环节,提升AI系统的可靠性、适应性与现实目标一致性。

对于数据解析、合规监控、客户流程等要求精准可靠的行业,这种混合模式已成必选项。

人参与环AI的优缺点

人参与环AI兼具显著优势和现实权衡,认清这些要素有助于企业合理规划人机协作比例。

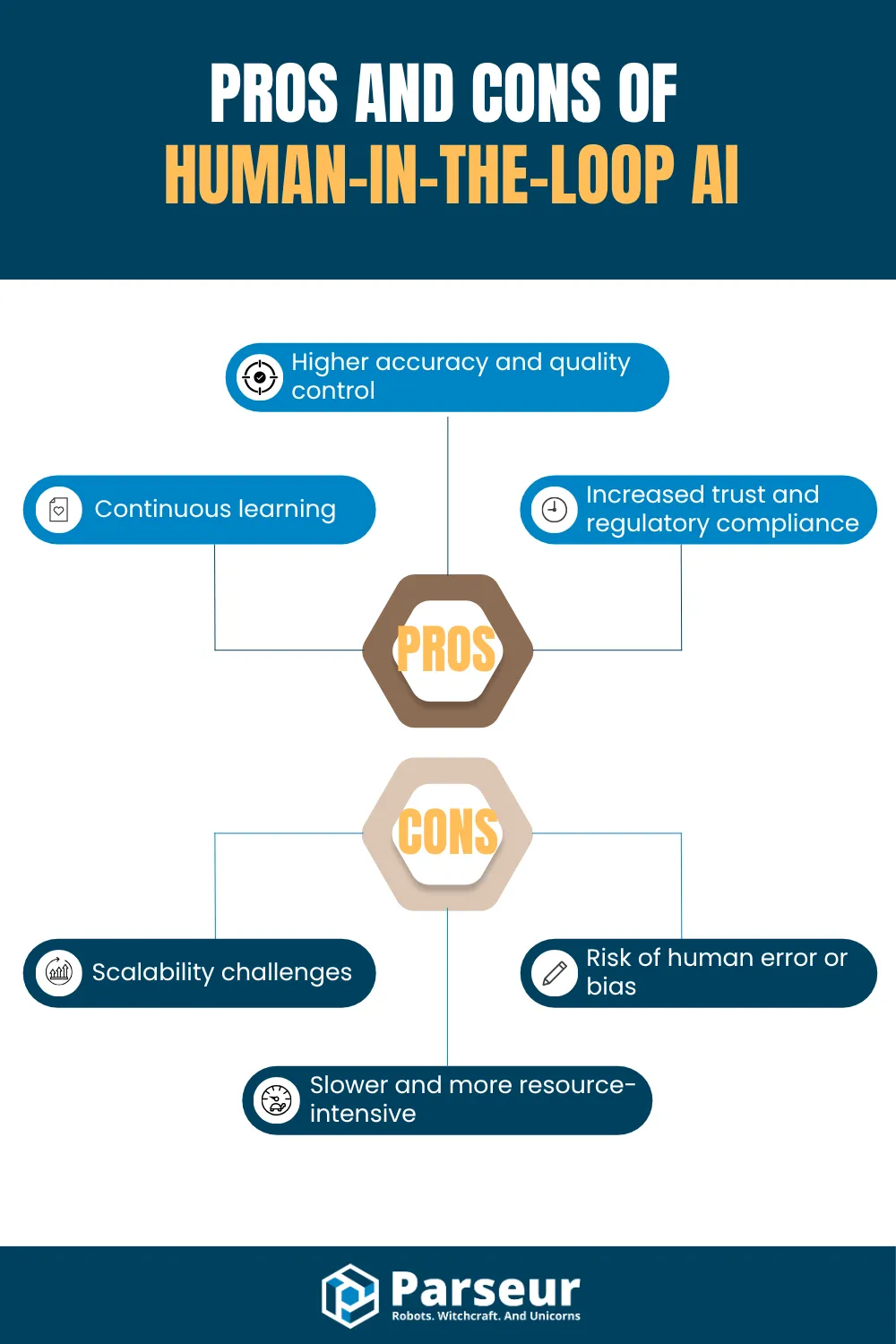

优势:

- 更高的准确率和质量管控:人类能纠正AI难以识别的复杂或模糊场景。

- 增强信任与合规性:人工监督让AI系统更透明,便于监管机构、合作伙伴和客户接受。

- 持续进步:不断的人工反馈促使AI模型螺旋式提升,修正和再训练能力更强。

劣势:

- 流程变慢、成本升高:引入人工降低自动化速度,并增加人力资源消耗。

- 扩展存在挑战:无合理管理时,人工参与难以线性扩大到大批量场景。

- 存在人为失误或偏见风险:人工虽能减少AI错误,也可能带入主观性与一致性问题。

2024年麦肯锡调研显示,27%的企业在使用生成式AI时会审核全部输出内容。这表明即使自动化普及,人工监督依然是保障质量的重要环节。

何时用人参与环AI VS 全自动AI

选用人参与环(HITL)还是全自动AI,需结合任务复杂度、出错后果及是否需要人工判断权衡。下表对比:

| 对比因素 | 人参与环AI | 全自动AI |

|---|---|---|

| 最佳应用场景 | 高风险、需主观判断、伦理或合规的复杂决策 | 重复、低风险、变化小的自动化任务 |

| 典型示例 | 医疗诊断、金融审批、招聘决策、法律审核 | 垃圾邮件过滤、图片标注、商品评论归类 |

| 人工角色 | 审核、纠正、引导AI输出 | 无或极少人工参与 |

| 出错后果 | 高:影响生命、合规、公平原则 | 低:损失可控、影响有限 |

| 灵活性要求 | 高:需逐案判断 | 低:任务可规则化、 predictable |

| 数据洞察 | 74%美企在招聘用人参与环工具 | 73%组织计划2027年前用AI自动化重复性任务 |

找到合适平衡点是关键:

- 错误代价高、伦理判别或数据复杂多变,建议采用人参与环AI。

- 任务简单、可扩展、对小失误可容忍,适合全自动AI。

结论

HITL AI通过在关键环节引入人工监督,为人工智能系统带来准确性、合规性和适应性,尤其适合高风险或动态变化的场景。组合自动化与人工判断,HITL提升了决策质量,加强了信任、问责和长期表现。

随着AI被更多企业采用,理解何时、如何引入人作为环节变得极为重要。HITL不是拉慢AI,而是让AI更智能、更安全、更贴合现实需要。

如需探索如何有效应用HITL、迎接AI发展变革,欢迎查阅我们的人参与环AI:定义、优势与2026趋势。深入了解实施方案、未来趋势及如何将HITL与业务目标结合。

最后更新于